As arquiteturas de implementação de segurança de rede passam por uma evolução regular, impulsionada por vários requisitos empresariais.

As arquiteturas de implementação de segurança de rede passam por uma evolução regular, impulsionada por vários requisitos empresariais.

Algumas das tendências recentes do setor estão descritas abaixo:

- Minimizar o custo e a carga de manutenção associados a sistemas de segurança de rede díspares e múltiplos.

- Implementar um mandato “Zero Trust Everywhere” que engloba todas as redes nos data centers, nas WANs e nos clusters do Kubernetes.

- Garantia de alto desempenho (throughput, latência reduzida e jitter mínimo) para aprimorar a experiência do usuário e oferecer suporte a aplicativos em tempo real, como o WebRTC.

- Atender às necessidades de uma força de trabalho distribuída.

- Atender às demandas da força de trabalho remota.

- Aumento da adoção de serviços SaaS pelas empresas.

- Dependência cada vez maior da nuvem para aplicativos corporativos.

- Adotar implantações em várias nuvens.

- Explorando as possíveis vantagens da computação de borda e névoa.

- Dificuldade em treinar ou adquirir pessoal qualificado em funções de rede e segurança.

- Minimizar os recursos necessários para gerenciar a conectividade de última milha da Internet para escritórios distribuídos.

Arquitetura de segurança e rede legada

Tradicionalmente, as empresas com vários escritórios e forças de trabalho remotas alocavam recursos substanciais para adquirir e manter sua infraestrutura de rede e segurança.

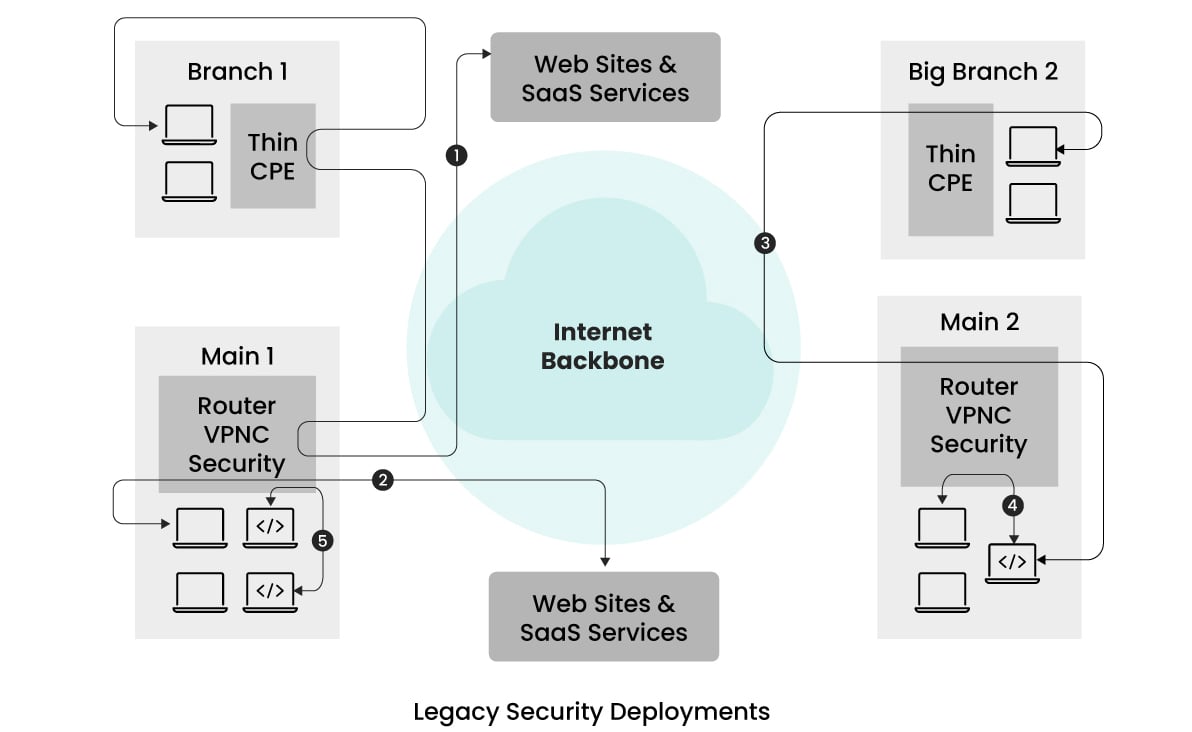

A ilustração simplificada abaixo mostra a arquitetura típica adotada anteriormente.  Este exemplo apresenta uma empresa com duas filiais e dois escritórios principais situados em diferentes partes do mundo.

Este exemplo apresenta uma empresa com duas filiais e dois escritórios principais situados em diferentes partes do mundo.

Em um esforço para reduzir as despesas com dispositivos de segurança e aliviar a sobrecarga de gerenciamento, toda a aplicação de segurança é centralizada nos escritórios principais.

O tráfego das filiais e dos usuários remotos é roteado para os escritórios principais mais próximos para aplicação da segurança antes de seguir para o destino pretendido.

Normalmente, os dispositivos “Thin CPE” são implantados nas filiais para facilitar esse túnel de tráfego.

Os escritórios principais são equipados com concentradores de VPN para terminar os túneis, vários dispositivos de segurança para detectar e remover explorações, implementar controles de acesso granular, proteger contra malware e impedir ataques de phishing.

No entanto, conforme ilustrado nos fluxos de tráfego (fluxos representados por 1 na figura), o tráfego das filiais para os sites da Internet segue uma rota com fio de cabelo.

Esse roteamento pode resultar em maior latência e, consequentemente, levar a experiências de usuário abaixo do ideal, especialmente se a filial e os escritórios principais próximos estiverem situados a uma distância considerável.

Algumas empresas tentaram aumentar a taxa de transferência e reduzir o jitter empregando links dedicados, mas essas soluções eram caras e não resolviam adequadamente os problemas de latência.

Além disso, o gerenciamento de vários dispositivos de rede e segurança, cada um com sua configuração exclusiva e painel de análise, apresenta desafios.

Essa complexidade pode resultar em configurações propensas a erros devido à necessidade de o pessoal ser treinado em várias interfaces.

Essas arquiteturas de segurança legadas geralmente ignoram os princípios de confiança zero, confiando mais na segmentação da rede e nos endereços IP, em vez de fornecer controle de acesso baseado no usuário, dependente da autenticação do usuário.

Embora essa abordagem funcionasse de forma eficaz naquela época, o aumento dos cenários de trabalho remoto e o uso extensivo de NAT (Network Address Translation) tornaram a identificação do usuário por meio de endereços IP cada vez mais desafiadora.

Consequentemente, esse esforço começou a revelar limitações nas arquiteturas legadas.

Segurança fornecida pela nuvem/POP

Em resposta aos desafios relacionados à manutenção da infraestrutura de segurança no local, à acomodação das demandas de trabalho remoto, à redução da latência associada à dispersão do tráfego e ao uso ampliado de serviços de nuvem e SaaS, as soluções de segurança baseadas em nuvem surgiram como uma alternativa promissora.

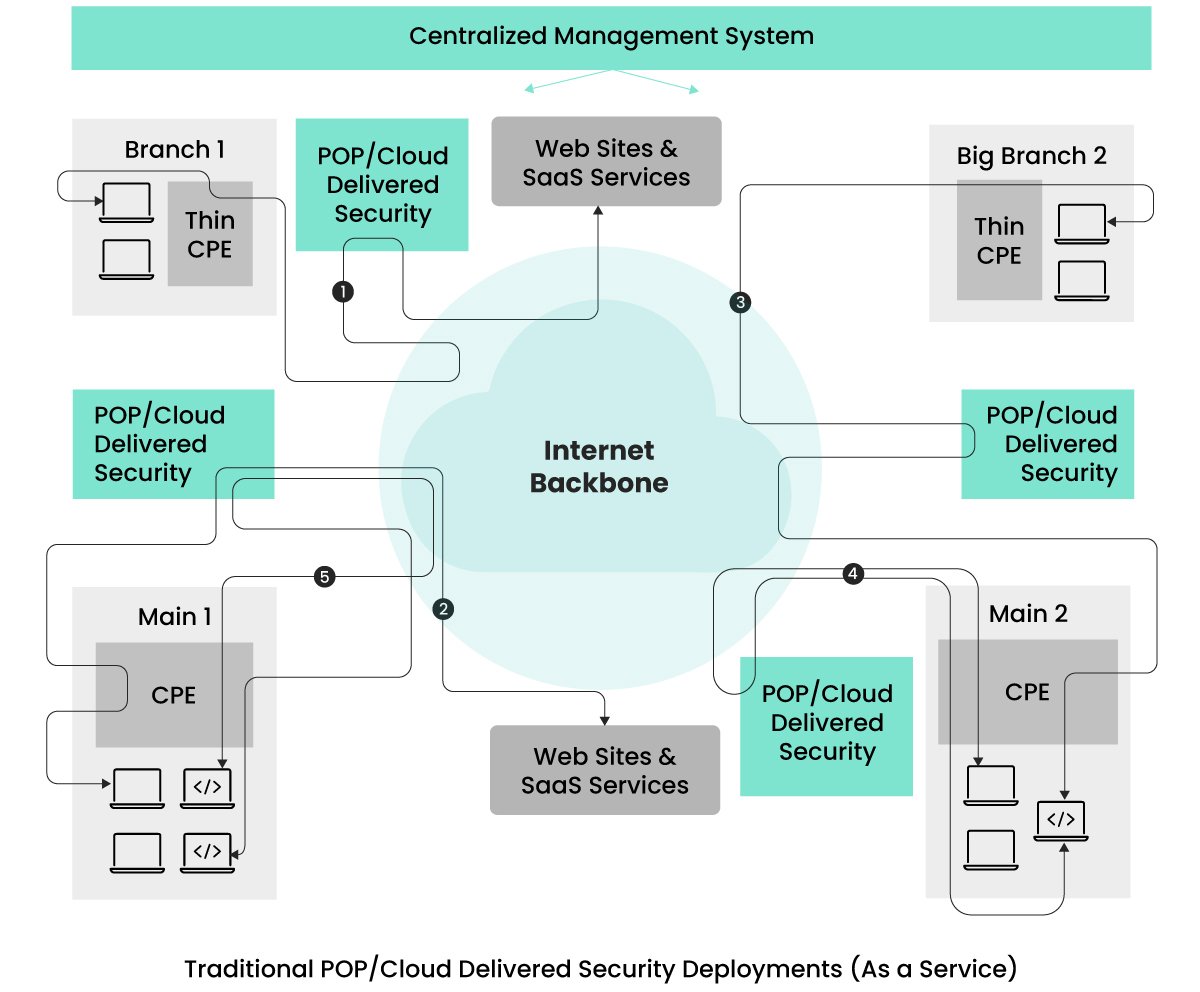

Muitas empresas começaram a aproveitar essas soluções de segurança fornecidas pela nuvem para resolver esses problemas, conforme mostrado na figura abaixo.  Os serviços de segurança são distribuídos pelo provedor por meio de vários pontos de presença (POPs).

Os serviços de segurança são distribuídos pelo provedor por meio de vários pontos de presença (POPs).

As empresas têm a flexibilidade de selecionar os locais dos POPs com base na localização de seus escritórios e na concentração de sua força de trabalho remota.

O tráfego de clientes destinado a qualquer local é roteado pelo POP mais próximo, onde a aplicação da segurança é aplicada.

Esse roteamento é facilitado pelo uso de dispositivos CPE em escritórios e software cliente VPN em dispositivos de usuários remotos, reduzindo a latência associada à arquitetura de segurança legada devido à proximidade dos locais POP.

Inicialmente, o setor contava com serviços de segurança de vários fornecedores, mas houve uma mudança para serviços de segurança em nuvem baseados em tecnologia unificada e de fornecedor único.

Esses serviços unificados oferecem configuração de segurança simplificada e gerenciamento de observabilidade, abordando o gerenciamento de segurança fragmentado das arquiteturas de implementação legadas.

Embora essa configuração tenha um bom desempenho para o tráfego destinado à Internet/sites de SaaS, ela apresenta um novo desafio quando as duas entidades comunicantes estão no mesmo site, data center ou em um cluster do Kubernetes, conforme visto nos fluxos (4) e (5).

O fluxo (4) mostra o tráfego entre entidades dentro do mesmo site sendo tunelizado para o local POP mais próximo e, em seguida, roteado de volta.

Isso é feito para impor medidas de segurança em todos os fluxos de tráfego, atendendo aos requisitos de confiança zero.

O fluxo (5) ilustra a comunicação entre dois serviços de aplicativos, que, para atender às demandas de confiança zero, é roteado para fora do site para o POP mais próximo para processamento de segurança antes de retornar ao mesmo cluster do Kubernetes.

Esse processo aumenta inadvertidamente a latência desses fluxos e pode expor o tráfego a entidades adicionais desnecessariamente.

Algumas empresas evitam essa latência implantando diferentes dispositivos de segurança no local, mas isso reintroduz desafios associados às arquiteturas de implantação herdadas.

Outro desafio com a segurança fornecida pelo POP está relacionado ao isolamento do desempenho.

Como esses provedores prestam serviços a vários clientes/locatários, há casos de desafios de desempenho relacionados a vizinhos barulhentos.

Ou seja, o volume de tráfego de outras empresas pode afetar o desempenho do tráfego da sua empresa.

Isso ocorre devido ao compartilhamento do mesmo contexto de execução para o tráfego proveniente de várias empresas.

À medida que as empresas buscam soluções que atendam aos requisitos de confiança zero, ofereçam gerenciamento unificado de políticas, forneçam isolamento de desempenho e reduzam a latência desnecessária do hair-pinning, o setor de segurança de rede evoluiu suas arquiteturas de implementação para atender a essas preocupações.

O SASE (Unified Secure Access Service Edge), fornecido por empresas como a Aryaka, surgiu para desempenhar um papel fundamental nesse cenário.

SASE unificado com serviços de segurança híbridos e distribuídos

Uma arquitetura ideal é aquela que alivia as complexidades de gerenciamento encontradas nas arquiteturas anteriores, atende aos rigorosos requisitos de confiança zero, garante um nível igual de segurança para os fluxos de tráfego Norte-Sul e Leste-Oeste, oferece gerenciamento unificado de políticas, fornece isolamento de desempenho e contorna os problemas de latência associados ao hair-pinning.

O SASE unificado de empresas como a Aryaka oferece uma arquitetura que atende a muitos dos requisitos acima.

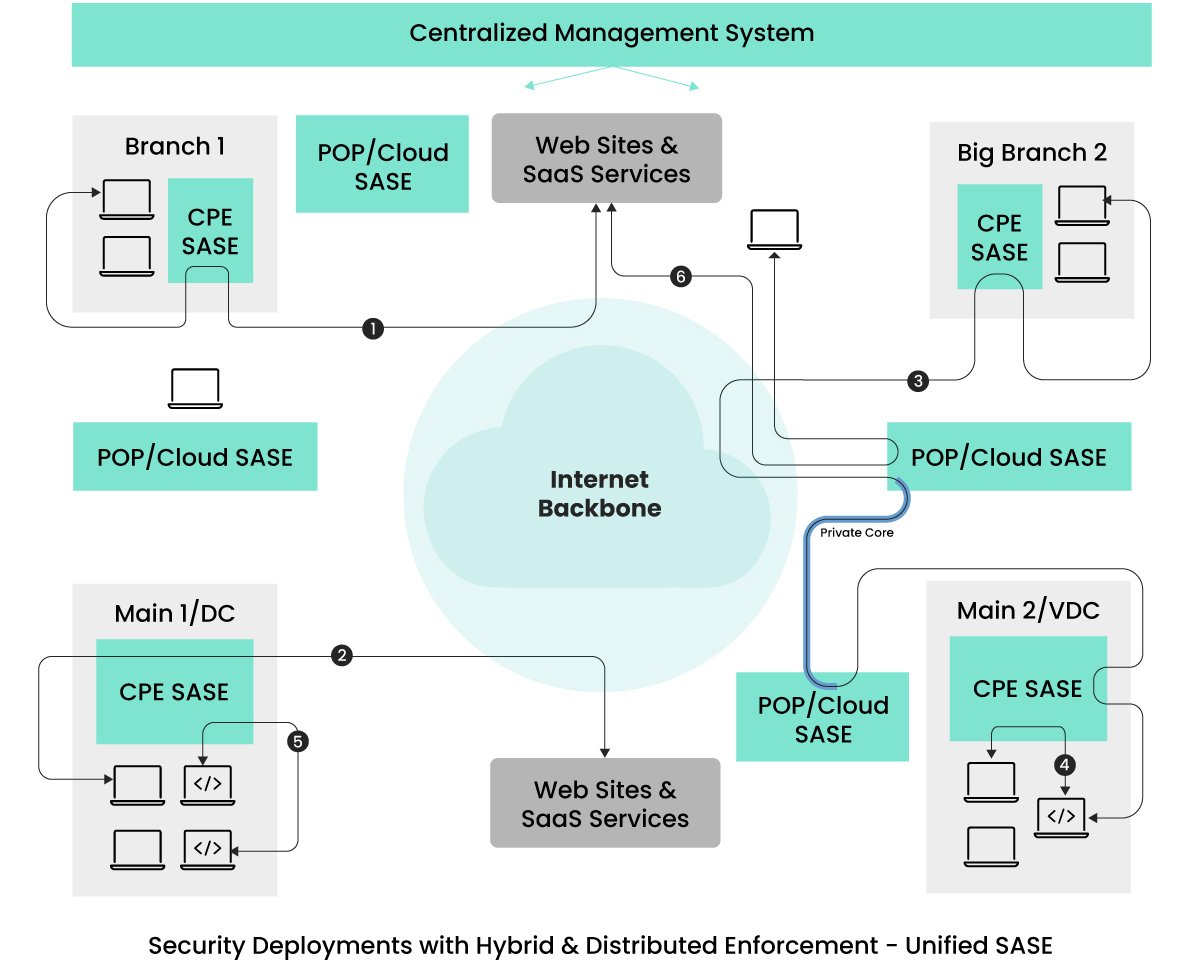

Veja a imagem abaixo.  Na arquitetura descrita, a aplicação da rede e da segurança se estende além dos locais POP/nuvem para abranger os dispositivos CPE, todos fornecidos e gerenciados de maneira uniforme pelo mesmo provedor de serviços.

Na arquitetura descrita, a aplicação da rede e da segurança se estende além dos locais POP/nuvem para abranger os dispositivos CPE, todos fornecidos e gerenciados de maneira uniforme pelo mesmo provedor de serviços.

Essa estratégia alivia as preocupações dos clientes com a manutenção desses dispositivos CPE.

Somente quando esses dispositivos encontrarem sobrecarga de tráfego, o novo tráfego será direcionado para locais POP próximos para aplicação da segurança.

O volume de tráfego redirecionado para os locais POP depende dos modelos de dispositivos CPE selecionados, reduzindo o tráfego de fallback.

Quanto ao tráfego de usuários de acesso remoto (representado como 6), ele segue um caminho semelhante ao das arquiteturas anteriores.

O tráfego de dispositivos de usuários remotos passa por processamento de rede e segurança no local POP mais próximo antes de chegar ao destino pretendido.

Os fluxos (1) e (2) nessa arquitetura ignoram os locais POP, eliminando até mesmo as latências mínimas presentes nas configurações fornecidas pela nuvem.

Além disso, os fluxos (4) e (5), contidos em um site, não apenas contornam as sobrecargas de latência, mas também reduzem a superfície de ataque.

Essa aplicação de segurança local é essencial para aplicativos em tempo real, como o WebRTC, sensível a problemas de latência.

Para serviços de aplicativos em sites diferentes que necessitam de desempenho determinístico e de baixa instabilidade, alguns provedores de SASE oferecem conectividade dedicada entre sites por meio dos POPs mais próximos.

O fluxo (3) exemplifica os fluxos de tráfego que se beneficiam da largura de banda e dos links dedicados, ignorando o backbone da Internet para obter um jitter determinístico.

É importante observar que nem todas as ofertas de SASE unificado são idênticas.

Alguns provedores de SASE ainda redirecionam todo o tráfego do escritório para os POPs mais próximos para otimização e segurança da rede.

Embora eles possam atenuar as despesas gerais de latência com vários locais POP, qualquer redução na latência é vantajosa para as empresas, especialmente na previsão de possíveis necessidades de aplicativos de baixa latência.

As empresas provavelmente buscarão soluções que priorizem a facilidade de uso e a segurança de alto nível sem comprometer o desempenho ou a experiência do usuário.

Dada a necessidade de baixo jitter entre os escritórios, as empresas devem considerar os provedores que oferecem links virtuais dedicados entre os escritórios que contornam o backbone da Internet.

Outro fator crucial para as empresas é selecionar provedores que gerenciem a manutenção e as atualizações de software dos dispositivos SASE-CPE.

Nos modelos antigos, as empresas assumiam a responsabilidade pelas atualizações e substituições.

Para evitar essa preocupação, as empresas devem considerar provedores de serviços que ofereçam serviços gerenciados abrangentes que cubram todo o ciclo de vida da infraestrutura SASE, incluindo tarefas como gerenciamento de dispositivos CPE (Customer Premises Equipment), configuração, atualizações, solução de problemas e observabilidade.

Esses provedores funcionam como balcões únicos, lidando com todos os aspectos da rede e da segurança e, ao mesmo tempo, oferecendo opções de cogerenciamento ou autoatendimento para as empresas.

Olhando para o futuro – SASE universal e unificada

Embora a estrutura arquitetônica existente, “SASE unificado com segurança distribuída”, atenda satisfatoriamente a vários requisitos iniciais detalhados no artigo, existem estratégias adicionais para melhorar o desempenho dos aplicativos sem comprometer a integridade da segurança.

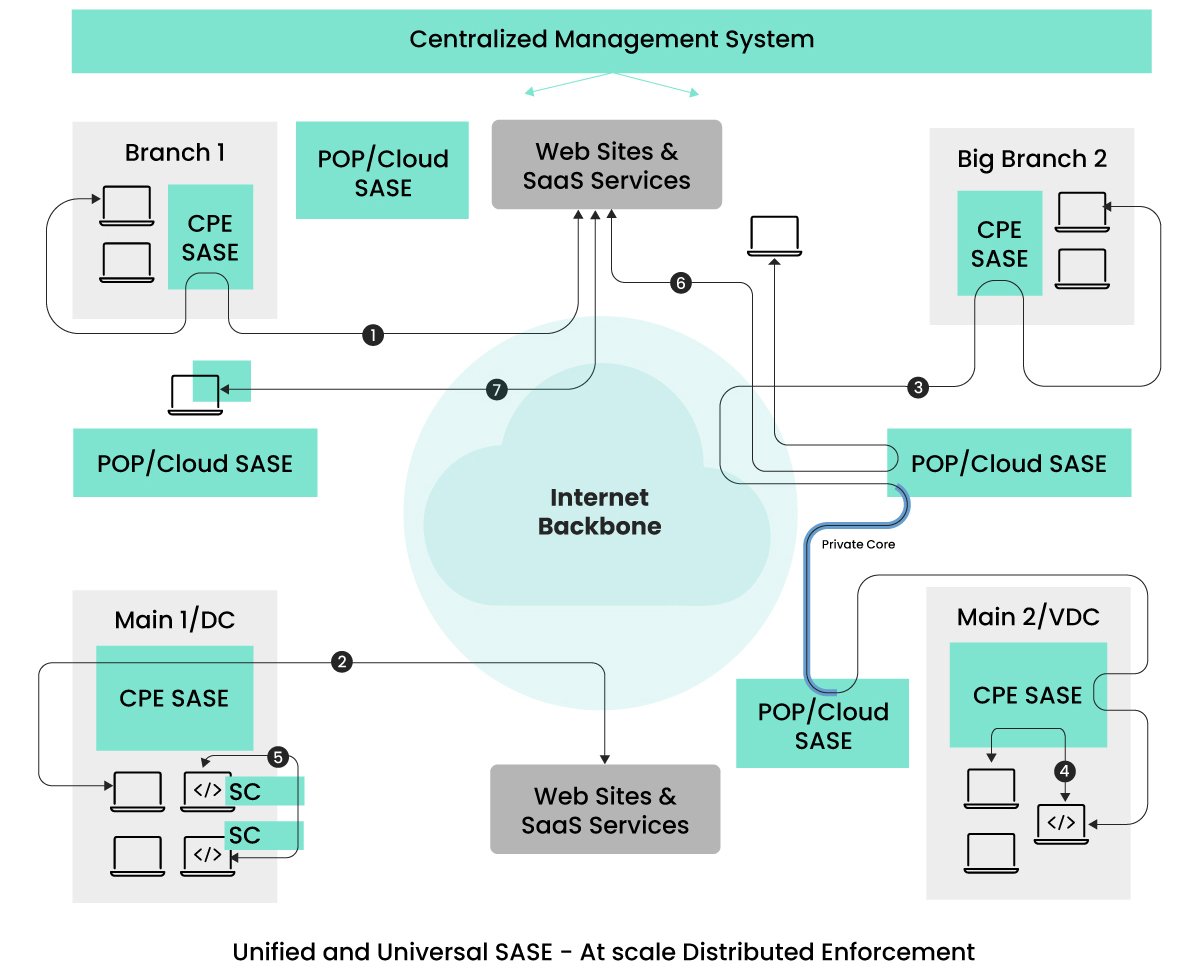

Ao olharmos para o futuro, prevemos avanços na aplicação da segurança e na otimização do tráfego além dos POPs e da borda dos escritórios.

Essas novas abordagens arquitetônicas terão como alvo os fluxos (5) e (7), com o objetivo específico de melhorar o aspecto de latência do desempenho.  Conforme ilustrado na figura, o conceito de implementar a segurança e a otimização universalmente, especialmente na origem do tráfego, pode gerar um desempenho ideal.

Conforme ilustrado na figura, o conceito de implementar a segurança e a otimização universalmente, especialmente na origem do tráfego, pode gerar um desempenho ideal.

Os principais fluxos de tráfego a serem observados estão representados em (5) e (7).

A prevalência de arquiteturas de aplicativos baseadas em micro/mini-serviços está se tornando padrão no cenário de aplicativos.

Esses minisserviços podem ser implantados em clusters do Kubernetes, espalhados por clusters dentro de data centers ou em diferentes localizações geográficas.

Em cenários em que os serviços de comunicação existem no mesmo cluster do Kubernetes, é vantajoso garantir que o tráfego permaneça dentro do cluster, permitindo a aplicação de segurança e otimização diretamente no ambiente do Kubernetes.

O Kubernetes facilita a adição de sidecars aos PODs que hospedam os minisserviços.

Prevemos que os provedores de SASE aproveitarão esse recurso no futuro para oferecer funções abrangentes de segurança e otimização, atendendo aos requisitos de confiança zero sem comprometer o desempenho.

Optar por um único provedor universal de SASE garante às empresas uma interface de gerenciamento unificada para todas as suas necessidades de segurança, independentemente do posicionamento dos serviços de comunicação.

O fluxo (5) na figura mostra a aplicação da segurança por meio de side-cars (SC).

É importante observar que os sidecars não são novidade no mundo do Kubernetes; as tecnologias de service mesh usam uma abordagem semelhante para o gerenciamento de tráfego.

Alguns provedores de service mesh começaram a integrar a segurança contra ameaças, como o WAAP, nos sidecars.

Considerando que os serviços podem se comunicar com a Internet e outros serviços de SaaS, medidas de segurança abrangentes são essenciais.

Consequentemente, é previsível que haja uma convergência de service mesh e SASE no futuro, já que as empresas buscam uma solução abrangente e unificada.

O tráfego representado como (7) é uma consideração que muitos provedores de SASE estão explorando, o que envolve não apenas a funcionalidade de cliente VPN, mas também a execução de funções de SASE diretamente no endpoint.

Estender a SASE aos endpoints ajuda a contornar qualquer problema de latência associado aos locais POP.

À medida que os terminais aumentam a capacidade de computação e oferecem controles aprimorados para evitar negações de serviço de entidades mal-intencionadas, tornou-se viável estender a aplicação da SASE aos terminais.

Enquanto os provedores de serviços lidam com o ônus da manutenção do SASE, as empresas ainda precisam garantir que a implementação do SASE nos endpoints não introduza novos problemas.

Portanto, as empresas buscam flexibilidade para permitir a extensão do SASE aos endpoints especificamente para usuários avançados.

Considerações finais

Este artigo ilustrou a evolução da rede e da segurança, traçando um curso desde sistemas legados até soluções modernas fornecidas em nuvem, SASE unificado com aplicação distribuída e projetos arquitetônicos futuros em perspectiva.

É fundamental reconhecer as variações nas ofertas de soluções.

As empresas devem realizar avaliações completas dos provedores de serviços, buscando soluções “como serviço” que abranjam a aplicação distribuída em PoPs e dispositivos CPE, incluindo atualizações de sistema operacional e software, ao mesmo tempo em que mantêm práticas de gerenciamento consistentes que sustentam a segurança e o desempenho.

Além disso, é fundamental que as empresas priorizem serviços gerenciados (ou co-gerenciados) de um único provedor.

Esses serviços não devem apenas fornecer soluções de conectividade com a Internet com suporte técnico avançado, mas também se adaptar rapidamente a novos requisitos e enfrentar ameaças emergentes.

Optar por um provedor de serviços gerenciados que use as-a-service de outros fornecedores de SASE pode levar a complicações em aprimoramentos futuros, implicando em negociações prolongadas entre os provedores de serviços gerenciados e de tecnologia.

Dada a necessidade imperativa de resoluções rápidas, acredito que as soluções SASE unificadas com ofertas abrangentes de serviços gerenciados de um único fornecedor são a escolha ideal para as empresas.

-

Blog CTO Insights

A série de blogs Aryaka CTO Insights oferece liderança de pensamento para tópicos de rede, segurança e SASE.

Para obter as especificações dos produtos Aryaka, consulte as fichas técnicas da Aryaka.