Les architectures de déploiement de la sécurité des réseaux évoluent régulièrement en fonction des besoins des entreprises.

Les architectures de déploiement de la sécurité des réseaux évoluent régulièrement en fonction des besoins des entreprises.

Certaines des tendances récentes de l’industrie sont décrites ci-dessous :

- Minimiser les coûts et la charge de maintenance associés à des systèmes de sécurité réseau disparates et multiples.

- Mettre en œuvre un mandat » Zero Trust Everywhere » qui englobe tous les réseaux au sein des centres de données, à travers les réseaux étendus et au sein des clusters Kubernetes.

- Garantir des performances élevées (débit, latence réduite et gigue minimale) pour améliorer l’expérience de l’utilisateur et prendre en charge des applications en temps réel telles que WebRTC.

- Répondre aux besoins d’une main-d’œuvre répartie.

- Répondre aux exigences de la main-d’œuvre à distance.

- Adoption accrue des services SaaS par les entreprises.

- La dépendance croissante à l’égard de l’informatique en nuage pour les applications d’entreprise.

- Adopter les déploiements multi-cloud.

- Explorer les avantages potentiels de l’informatique en périphérie et de l’informatique en nuage.

- Difficulté à former ou à acquérir du personnel qualifié dans les domaines du réseau et de la sécurité.

- Minimiser les ressources nécessaires à la gestion de la connectivité Internet du dernier kilomètre pour les bureaux distribués.

Architecture patrimoniale du réseau et de la sécurité

Les entreprises disposant de plusieurs bureaux et d’une main-d’œuvre distante allouaient traditionnellement des ressources substantielles à l’acquisition et à la maintenance de leur infrastructure de réseau et de sécurité.

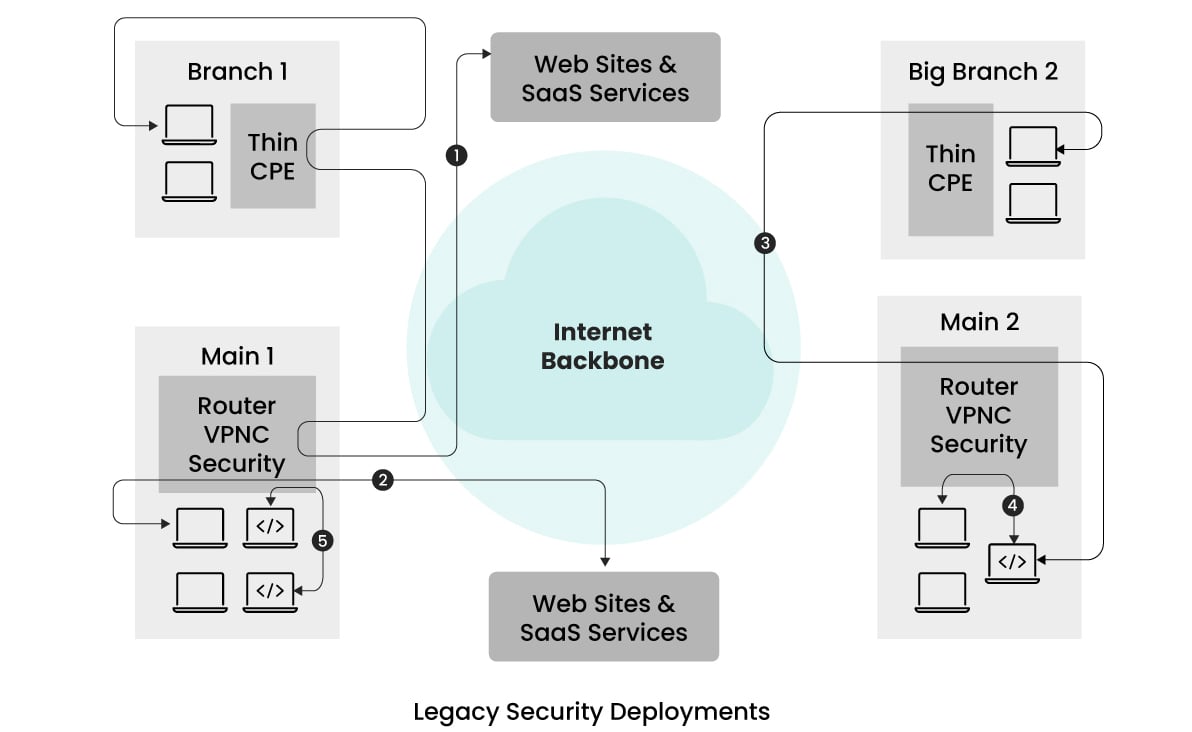

L’illustration simplifiée ci-dessous montre l’architecture typique adoptée précédemment.  Cet exemple présente une entreprise disposant de deux succursales et de deux bureaux principaux situés dans différentes parties du monde.

Cet exemple présente une entreprise disposant de deux succursales et de deux bureaux principaux situés dans différentes parties du monde.

Afin de réduire les dépenses liées aux équipements de sécurité et d’alléger les frais de gestion, toutes les mesures de sécurité sont centralisées dans les bureaux principaux.

Le trafic en provenance des succursales et des utilisateurs distants est acheminé vers les bureaux principaux les plus proches pour y être sécurisé avant d’être acheminé vers sa destination.

Des dispositifs « Thin CPE » sont généralement déployés dans les succursales pour faciliter le tunnelage du trafic.

Les bureaux principaux sont équipés de concentrateurs VPN pour terminer les tunnels, de multiples dispositifs de sécurité pour détecter et supprimer les exploits, mettre en œuvre des contrôles d’accès granulaires, se protéger contre les logiciels malveillants et prévenir les attaques par hameçonnage.

Cependant, comme l’illustrent les flux de trafic (flux représentés par 1 dans l’image), le trafic entre les succursales et les sites Internet suit un itinéraire en épingle à cheveux.

Cet acheminement peut entraîner une augmentation de la latence et, par conséquent, des expériences sous-optimales pour les utilisateurs, en particulier si la succursale et les bureaux principaux voisins sont situés à une distance considérable l’un de l’autre.

Certaines entreprises ont tenté d’améliorer le débit et de réduire la gigue en employant des liaisons spécialisées, mais ces solutions étaient coûteuses et ne permettaient pas de résoudre les problèmes de latence de manière satisfaisante.

En outre, la gestion de multiples dispositifs de réseau et de sécurité, chacun avec sa propre configuration et son propre tableau de bord analytique, pose des problèmes.

Cette complexité peut entraîner des configurations sujettes aux erreurs en raison de la nécessité pour le personnel d’être formé à de multiples interfaces.

Ces anciennes architectures de sécurité ont souvent négligé les principes de confiance zéro, s’appuyant davantage sur la segmentation du réseau et les adresses IP que sur un contrôle d’accès basé sur l’authentification de l’utilisateur.

Bien que cette approche ait fonctionné efficacement à l’époque, l’augmentation des scénarios de travail à distance et l’utilisation généralisée du NAT (Network Address Translation) ont rendu l’identification des utilisateurs par le biais des adresses IP de plus en plus difficile.

Par conséquent, cette contrainte a commencé à révéler les limites des architectures existantes.

Sécurité fournie par le Cloud/POP

En réponse aux défis liés au maintien d’une infrastructure de sécurité sur site, à la prise en compte des exigences du travail à distance, à la réduction de la latence associée à l’empilement du trafic et à l’utilisation accrue des services en nuage et SaaS, les solutions de sécurité basées sur l’informatique en nuage sont apparues comme une alternative prometteuse.

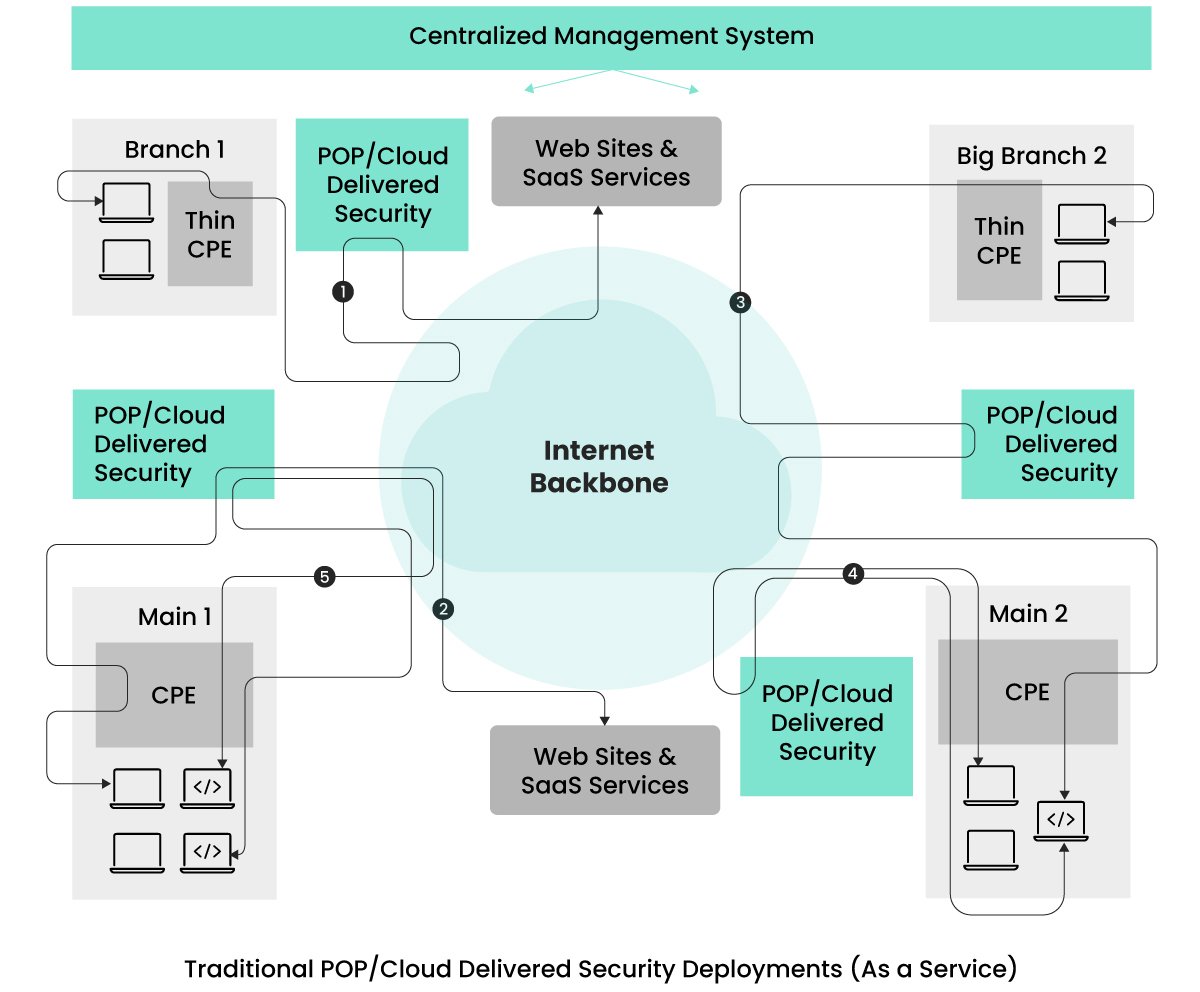

De nombreuses entreprises ont commencé à tirer parti de ces solutions de sécurité en nuage pour résoudre ces problèmes, comme le montre l’image ci-dessous.  Les services de sécurité sont distribués par le fournisseur via différents points de présence (POP).

Les services de sécurité sont distribués par le fournisseur via différents points de présence (POP).

Les entreprises ont la possibilité de choisir l’emplacement des points de présence en fonction de l’emplacement de leurs bureaux et de la concentration de leur personnel à distance.

Le trafic des clients à destination de n’importe quel endroit est acheminé par le point de présence le plus proche où la sécurité est appliquée.

Ce routage est facilité par l’utilisation d’appareils CPE dans les bureaux et de logiciels clients VPN sur les appareils des utilisateurs distants, ce qui réduit le temps de latence associé à l’ancienne architecture de sécurité en raison de la proximité des emplacements POP.

Au départ, l’industrie proposait des services de sécurité provenant de plusieurs fournisseurs, mais on assiste à une évolution vers des services de sécurité en nuage basés sur une technologie unifiée et provenant d’un seul fournisseur.

Ces services unifiés offrent une configuration de sécurité rationalisée et une gestion de l’observabilité, ce qui permet de remédier à la gestion fragmentée de la sécurité des anciennes architectures de déploiement.

Si cette configuration fonctionne bien pour le trafic destiné aux sites Internet/SaaS, elle introduit un nouveau défi lorsque les deux entités communicantes se trouvent sur le même site, dans le même centre de données ou au sein d’un cluster Kubernetes, comme on le voit dans les flux (4) et (5).

Le flux (4) montre que le trafic entre les entités d’un même site est acheminé vers l’emplacement POP le plus proche, puis réacheminé.

Cela permet d’appliquer des mesures de sécurité à tous les flux de trafic et de répondre aux exigences de confiance zéro.

Le flux (5) illustre la communication entre deux services d’application qui, pour répondre aux exigences de confiance zéro, est acheminée hors du site vers le POP le plus proche pour un traitement de sécurité avant de retourner dans le même cluster Kubernetes.

Ce processus augmente involontairement la latence pour ces flux et peut exposer inutilement le trafic à des entités supplémentaires.

Certaines entreprises évitent cette latence en déployant différentes appliances de sécurité sur site, mais cela réintroduit les défis associés aux architectures de déploiement héritées.

Un autre problème posé par la sécurité fournie par les POP est lié à l’isolation des performances.

Étant donné que ces fournisseurs offrent leurs services à de multiples clients/locataires, il existe des cas de problèmes de performances liés à des voisins bruyants.

En d’autres termes, le volume de trafic des autres entreprises peut avoir un impact sur les performances du trafic de votre entreprise.

Cela est dû au partage du même contexte d’exécution pour le trafic provenant de plusieurs entreprises.

Alors que les entreprises recherchent des solutions qui répondent aux exigences de confiance zéro, offrent une gestion unifiée des politiques, assurent l’isolation des performances et réduisent les temps de latence inutiles, le secteur de la sécurité des réseaux a fait évoluer ses architectures de déploiement pour répondre à ces préoccupations.

Le Secure Access Service Edge (SASE) unifié, fourni par des sociétés telles qu’Aryaka, a émergé pour jouer un rôle central dans ce paysage.

SASE unifié avec des services de sécurité hybrides et distribués

L’architecture idéale est celle qui allège les complexités de gestion rencontrées dans les architectures précédentes, répond aux exigences strictes de confiance zéro, assure un niveau de sécurité égal pour les flux de trafic Nord-Sud et Est-Ouest, offre une gestion unifiée des politiques, fournit une isolation des performances et contourne les problèmes de latence liés à l’épinglage.

Les SASE unifiés proposés par des sociétés telles qu’Aryaka offrent une architecture qui répond à bon nombre des exigences susmentionnées.

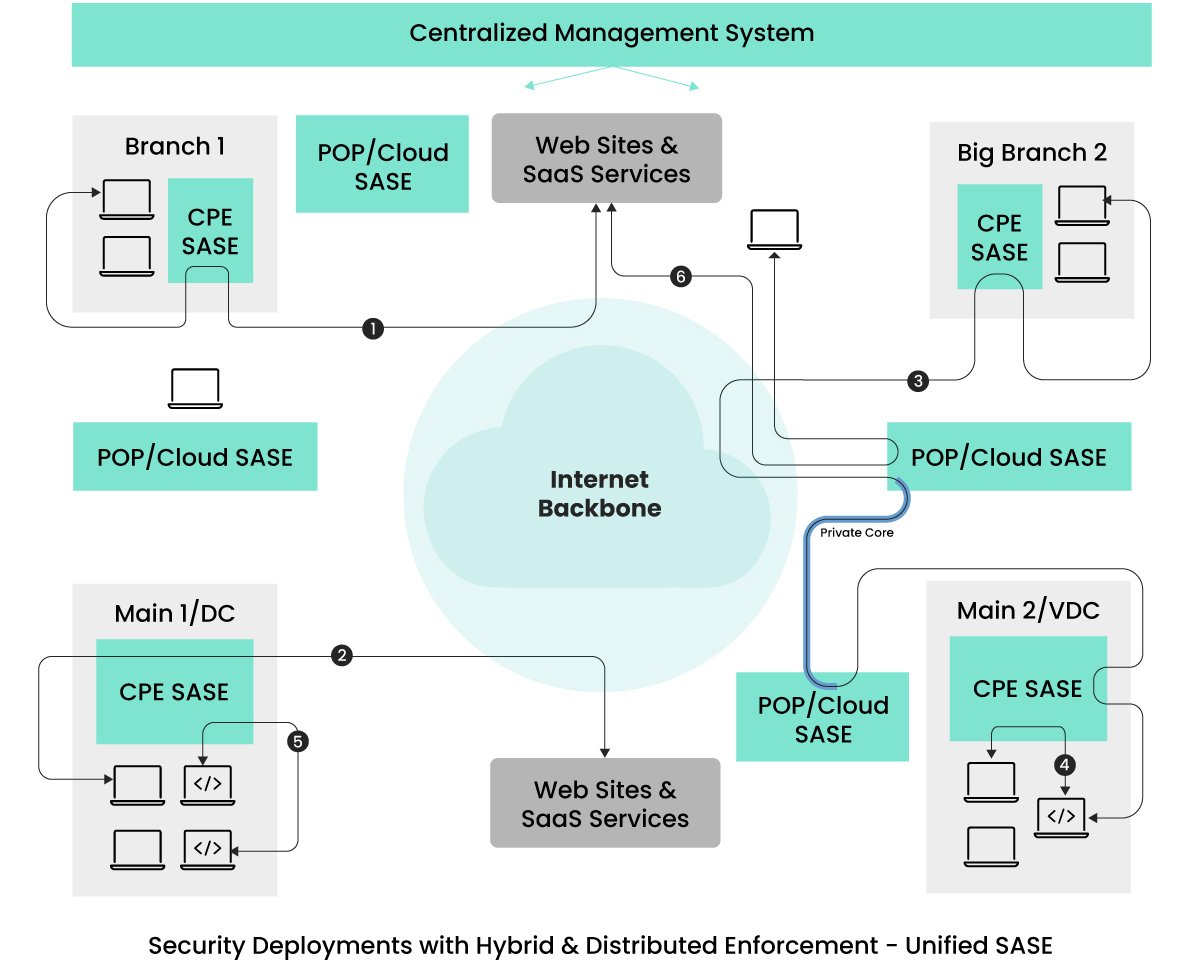

Veuillez consulter l’image ci-dessous.  Dans l’architecture décrite, l’application du réseau et de la sécurité s’étend au-delà des sites POP/Cloud pour englober les appareils CPE, tous fournis et gérés uniformément par le même fournisseur de services.

Dans l’architecture décrite, l’application du réseau et de la sécurité s’étend au-delà des sites POP/Cloud pour englober les appareils CPE, tous fournis et gérés uniformément par le même fournisseur de services.

Cette stratégie atténue les inquiétudes des clients quant à la maintenance de ces dispositifs CPE.

Ce n’est que lorsque ces dispositifs rencontrent une surcharge de trafic que le nouveau trafic est dirigé vers les sites POP proches pour l’application de la sécurité.

Le volume de trafic réacheminé vers les sites POP dépend des modèles d’appareils CPE sélectionnés, ce qui réduit le trafic de secours.

En ce qui concerne le trafic provenant des utilisateurs à distance (représenté par le point 6), il suit un chemin similaire à celui des architectures précédentes.

Le trafic provenant des dispositifs d’utilisateurs distants subit un traitement de réseau et de sécurité au point d’accès le plus proche avant d’atteindre sa destination prévue.

Les flux (1) et (2) de cette architecture contournent les points d’accès publics, éliminant ainsi les temps de latence, même minimes, présents dans les configurations fournies par l’informatique dématérialisée.

En outre, les flux (4) et (5), contenus dans un site, ne contournent pas seulement les surcharges de latence, mais réduisent également la surface d’attaque.

Cette application locale de la sécurité est essentielle pour les applications en temps réel telles que WebRTC, sensibles aux problèmes de latence.

Pour les services d’application dans différents sites nécessitant une performance déterministe et à faible gigue, certains fournisseurs de SASE offrent une connectivité dédiée entre les sites via les emplacements POP les plus proches.

Le flux (3) est un exemple de flux de trafic bénéficiant d’une bande passante et de liens dédiés, contournant la dorsale Internet pour obtenir une gigue déterministe.

Il est important de noter que toutes les offres de SASE unifiés ne sont pas identiques.

Certains fournisseurs de SASE redirigent encore tout le trafic des bureaux vers les points de vente les plus proches afin d’optimiser le réseau et d’assurer la sécurité.

Bien qu’ils puissent atténuer les frais généraux liés à la latence grâce à plusieurs sites POP, toute réduction de la latence s’avère avantageuse pour les entreprises, en particulier en prévision des besoins potentiels d’applications à faible latence.

Les entreprises rechercheront probablement des solutions qui privilégient la convivialité et la sécurité de haut niveau sans compromettre les performances ou l’expérience de l’utilisateur.

Étant donné la nécessité d’une faible gigue entre les bureaux, les entreprises devraient envisager des fournisseurs offrant des liaisons virtuelles dédiées entre les bureaux qui contournent la dorsale Internet.

Un autre facteur crucial pour les entreprises est la sélection de fournisseurs qui gèrent la maintenance et les mises à jour logicielles des appareils SASE-CPE.

Dans les modèles existants, les entreprises sont responsables des mises à jour et des remplacements.

Pour éviter ce problème, les entreprises devraient envisager de faire appel à des fournisseurs de services qui proposent des services complets de gestion en blanc couvrant l’ensemble du cycle de vie de l’infrastructure SASE et englobant des tâches telles que la gestion, la configuration, les mises à niveau, le dépannage et l’observabilité des appareils CPE (Customer Premises Equipment).

Ces fournisseurs sont des guichets uniques qui gèrent tous les aspects du réseau et de la sécurité, tout en offrant aux entreprises des options de cogestion ou de libre-service.

Perspectives d’avenir – SASE universel et unifié

Bien que le cadre architectural existant, « SASE unifié avec sécurité distribuée », réponde de manière satisfaisante à plusieurs exigences initiales détaillées dans l’article, il existe des stratégies supplémentaires pour améliorer les performances des applications sans compromettre l’intégrité de la sécurité.

Pour l’avenir, nous prévoyons des avancées dans l’application de la sécurité et l’optimisation du trafic au-delà des POP et de la périphérie des bureaux.

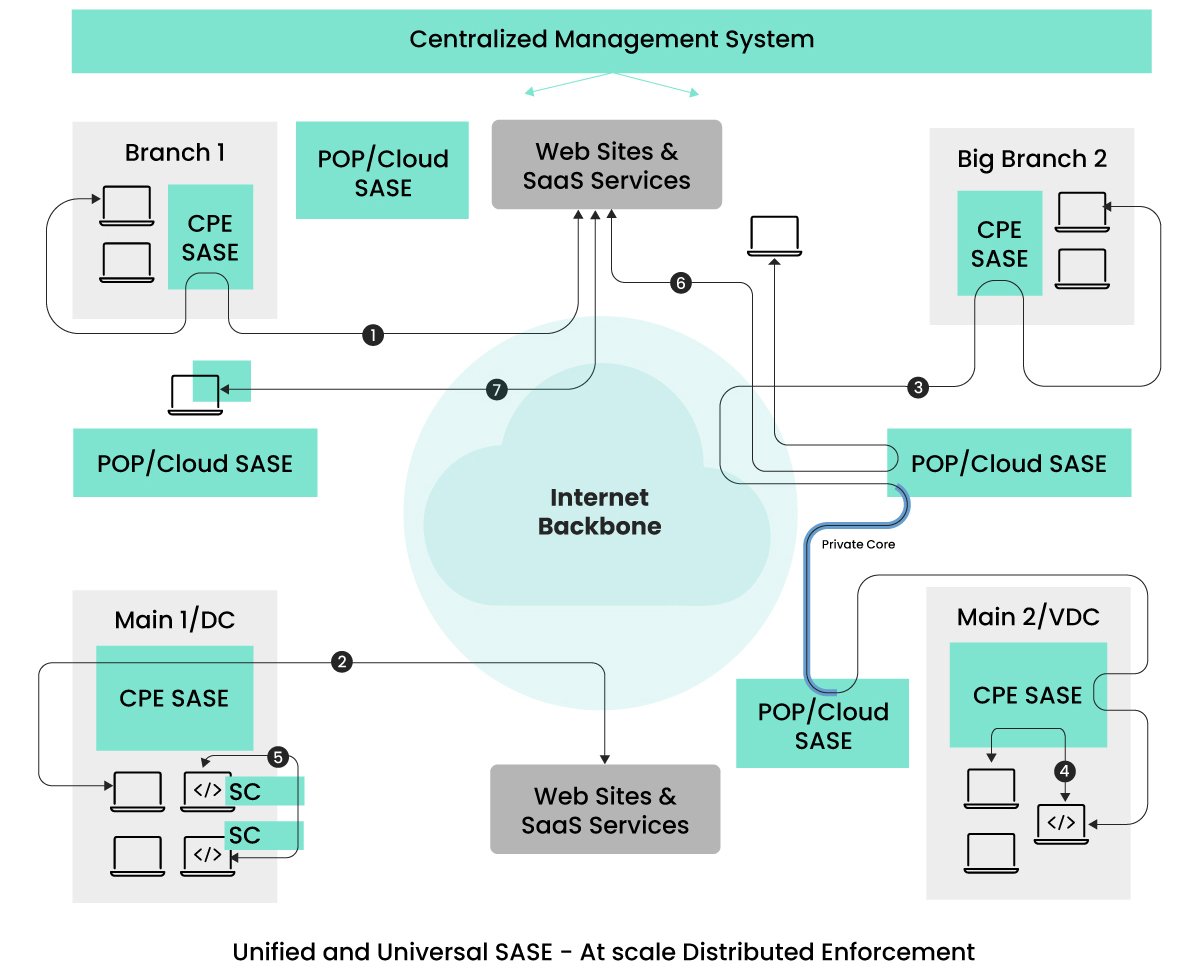

Ces nouvelles approches architecturales cibleront les flux (5) et (7) et viseront spécifiquement à améliorer l’aspect latence de la performance.  Comme le montre l’image, le concept de mise en œuvre universelle de la sécurité et de l’optimisation, en particulier à l’origine du trafic, peut permettre d’obtenir des performances optimales.

Comme le montre l’image, le concept de mise en œuvre universelle de la sécurité et de l’optimisation, en particulier à l’origine du trafic, peut permettre d’obtenir des performances optimales.

Les principaux flux de trafic à noter sont représentés par les points (5) et (7).

La prévalence des architectures d’application basées sur les micro/mini-services devient la norme dans le paysage applicatif.

Ces mini-services peuvent être déployés au sein de clusters Kubernetes, répartis sur des clusters au sein de centres de données, ou sur différents sites géographiques.

Dans les scénarios où les services communicants existent au sein du même cluster Kubernetes, il est avantageux de s’assurer que le trafic reste au sein du cluster, ce qui permet l’application de la sécurité et de l’optimisation directement au sein de l’environnement Kubernetes.

Kubernetes facilite l’ajout de sidecars aux PODs hébergeant les mini-services.

Nous prévoyons que les fournisseurs de SASE tireront parti de cette fonctionnalité à l’avenir pour offrir des fonctions de sécurité et d’optimisation complètes, répondant aux exigences de confiance zéro sans compromettre les performances.

En optant pour un fournisseur SASE universel unique, les entreprises disposent d’une interface de gestion unifiée pour tous leurs besoins en matière de sécurité, quel que soit l’emplacement des services communicants.

Le flux (5) de l’image représente l’application de la sécurité via les side-cars (SC).

Il est important de noter que les side-cars ne sont pas une nouveauté dans le monde Kubernetes ; les technologies de maillage de services utilisent une approche similaire pour la gestion du trafic.

Certains fournisseurs de services maillés ont commencé à intégrer la sécurité contre les menaces, comme WAAP, dans les side-cars.

Étant donné que les services peuvent communiquer avec l’internet et d’autres services SaaS, des mesures de sécurité complètes sont essentielles.

Par conséquent, il est prévisible qu’il y aura une convergence entre le service mesh et le SASE à l’avenir, car les entreprises recherchent une solution complète et unifiée.

Le trafic décrit en (7) est une considération que de nombreux fournisseurs de SASE explorent, ce qui implique non seulement d’avoir une fonctionnalité de client VPN mais aussi d’exécuter des fonctions SASE directement sur le point d’extrémité.

L’extension du SASE aux points d’extrémité permet de contourner les problèmes de latence associés aux points d’accès (POP).

À mesure que les terminaux gagnent en puissance de calcul et offrent des contrôles améliorés pour prévenir les dénis de service de la part d’entités malveillantes, il est devenu possible d’étendre l’application des SASE aux terminaux.

Alors que les fournisseurs de services se chargent de la maintenance du SASE, les entreprises peuvent avoir besoin de s’assurer que la mise en œuvre du SASE sur les points d’extrémité n’introduit pas de nouveaux problèmes.

C’est pourquoi les entreprises recherchent une certaine flexibilité en permettant l’extension du SASE aux points finaux, en particulier pour les utilisateurs expérimentés.

Réflexions finales

Cet article a illustré l’évolution des réseaux et de la sécurité, en traçant une voie depuis les anciens systèmes jusqu’aux solutions modernes fournies par l’informatique en nuage, en passant par le SASE unifié avec une mise en œuvre distribuée, et en proposant des conceptions architecturales futures.

Il est essentiel de reconnaître les différences entre les solutions proposées.

Les entreprises doivent procéder à des évaluations approfondies des fournisseurs de services, en recherchant des solutions « as-a-service » qui couvrent l’application distribuée à travers les PoP et les appareils CPE, en englobant les mises à jour des systèmes d’exploitation et des logiciels, tout en maintenant des pratiques de gestion cohérentes qui préservent à la fois la sécurité et les performances.

En outre, il est essentiel pour les entreprises de donner la priorité aux services gérés (ou cogérés) par un fournisseur unique.

Ces services doivent non seulement fournir des solutions de connectivité internet avec un support technique avancé, mais aussi s’adapter rapidement aux nouvelles exigences et répondre aux menaces émergentes.

Opter pour un fournisseur de services gérés qui utilise les services d’autres fournisseurs de SASE peut entraîner des complications dans les améliorations futures, entraînant des négociations prolongées entre les fournisseurs de services gérés et les fournisseurs de technologie.

Étant donné le besoin impératif de résolutions rapides, je pense que les solutions SASE unifiées avec des offres de services gérés complètes d’un seul fournisseur constituent le choix idéal pour les entreprises.

-

Blog CTO Insights

La série de blogs Aryaka CTO Insights fournit un leadership éclairé sur les thèmes du réseau, de la sécurité et de la SASE.

Pour les spécifications des produits Aryaka, consultez les fiches techniques d’Aryaka.