Latence, perte de paquets, distance et performance des applications.

Quel est le rapport entre tous ces termes ?

Si vous gérez les réseaux informatiques d’une entreprise internationale, il est important de prendre du recul et d’avoir une vue d’ensemble, afin de voir plus clairement comment ils s’influencent les uns les autres.

Pour certains d’entre vous, il s’agit peut-être d’un cours de mise en réseau, mais il est essentiel de comprendre les relations entre ces termes et leur impact combiné sur les performances des applications.

Définitions :

- (Réseau) La latence est l’expression du temps nécessaire à un paquet de données pour aller d’un point désigné à un autre.

- La perte de paquets est le fait qu’un ou plusieurs paquets transmis (qu’il s’agisse de données, de voix ou de vidéo) n’arrivent pas à destination.

- La distance est l’espace qui sépare deux points ou, dans le cas des réseaux d’entreprise, deux bureaux.

- TCP (Transmission Control Protocol) est une norme qui définit la manière d’établir et de maintenir une conversation réseau par laquelle les programmes d’application peuvent échanger des données.

La situation dans son ensemble :

Lorsqu’il y a une certaine distance entre le serveur d’origine et l’utilisateur qui accède à ce serveur, l’utilisateur a besoin d’un réseau fiable pour se connecter.

Ce réseau peut être privé, comme une liaison point à point ou MPLS.

Il peut également être public, généralement sur l’internet.

Si le réseau présente une perte de paquets, le débit global entre le serveur et l’utilisateur diminue considérablement avec l’augmentation de la distance.

Cela signifie que plus l’utilisateur est éloigné du serveur d’origine, plus le réseau devient inutilisable.

Comment cela se fait-il ?

Le principal responsable est le TCP (Transmission Control Protocol), la norme qui définit la manière d’établir et de maintenir une conversation réseau par laquelle les programmes d’application échangent des données.

TCP est le protocole ou le mécanisme qui assure la livraison fiable, ordonnée et vérifiée des données entre les serveurs et les utilisateurs à travers un réseau.

TCP est un bon gars et contribue à la qualité des données.

Il s’agit également d’un protocole orienté connexion, c’est-à-dire un mode de communication de données dans lequel vous devez d’abord établir une connexion avec un hôte ou un serveur distant avant de pouvoir envoyer des données.

L’étape suivante, après l’établissement d’une connexion TCP, consiste à établir un contrôle de flux pour déterminer la vitesse à laquelle l’expéditeur peut envoyer des données et la fiabilité avec laquelle le destinataire peut recevoir ces données.

En fonction de la qualité du réseau, le flux sera déterminé par la taille des fenêtres négociée par les deux parties.

Les extrémités peuvent être en désaccord si le client et le serveur perçoivent différemment les caractéristiques du réseau. Cela a un impact majeur sur les performances de l’application! Certaines applications telles que FTP utilisent un flux unique et s’adaptent à la taille maximale de la fenêtre disponible pour mener à bien l’opération.

En revanche, les applications basées sur des fenêtres ont tendance à être plus « bavardes » et nécessitent de multiples allers-retours pour mener à bien la ou les opérations.

Le modèle simpliste à considérer :

Réseau + perte de paquets + latence élevée = performance des applications TCP.

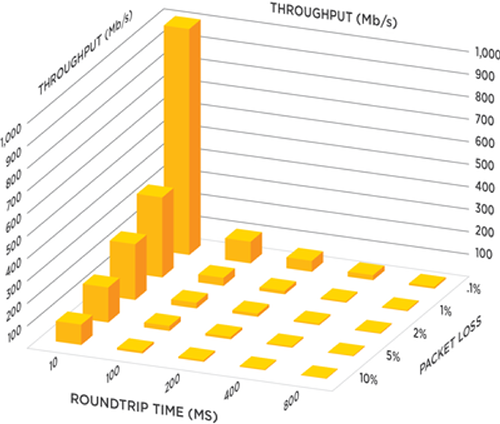

En fait, en regardant le graphique sur le débit maximal que l’on peut atteindre, on se demande comment les organisations parviennent à collaborer sur de longues distances.

Débit maximal de TCP en fonction de l’augmentation de la distance du réseau

Débit maximal de TCP en fonction de l’augmentation de la distance du réseau

La voix et la vidéo n’obtiennent pas de bons résultats lorsqu’il y a perte de paquets, en particulier sur les liaisons Internet à longue distance.

Cependant, une perte de paquets même minime, combinée à la latence et à la gigue, rendra un réseau inutilisable pour le trafic en temps réel.

Pourquoi ?

Parce que ces applications utilisent le protocole UDP (User Datagram Protocol).

Contrairement à TCP, le bon gars qui contrôle toutes les interactions, UDP n’en a que faire.

L’UDP est sans connexion, sans échange de données avant une opération, et expose à l’utilisateur tout manque de fiabilité du réseau sous-jacent.

Il n’y a aucune garantie de livraison.

Voici la voie que la plupart des organisations ayant une base d’utilisateurs mondiale et des problèmes croissants de performance des applications ont tendance à emprunter.

- Mettez l’accent sur les liens Internet.

Achetez plus de bande passante .

Throughput typically increases somewhat but not enough to fix the issue. - Passer à des liaisons MPLS.

Attendre 6 à 9 mois pour le déploiement.

Réalisez que le problème n’a pas été résolu pour les connexions longue distance. - Consommer de plus en plus de bande passante.

Déployez un système de qualité de service pour gérer la congestion et son impact sur le trafic en temps réel.

La voix et la vidéo s’en sortent bien, à condition qu’une bande passante suffisante soit configurée. - Réalisez que vous ne pouvez pas vous permettre de continuer à acheter de la bande passante à ce rythme alarmant.

- Ajoutez des dispositifs d’optimisation du réseau étendu.

Grâce à l’optimisation TCP, à la compression des données et aux proxys d’application, il est possible de résoudre les problèmes de débit. - Vous voyez les prix monter en flèche pour la gestion et la maintenance du matériel d’optimisation WAN, et vous subissez le choc des prix lorsque le moment est venu de rafraîchir ces appareils.

- Réfléchissez à vos options.

Services en nuage ?

Mobilité ? - Réexaminez l’ensemble de la conception du réseau de votre entreprise.

Faites le vœu de transformer ce réseau.

Prévoyez l’informatique en nuage et la mobilité.

Tenez compte du Big Data et de vos besoins croissants.

Prenez en compte les acquisitions et les changements d’activité.

Et comment feriez-vous ?

Si vous savez que le statu quo est rompu, vous savez aussi que les fournisseurs de matériel traditionnels essaient de tirer jusqu’au dernier centime de ces boîtes avant que leur modèle d’entreprise ne devienne complètement obsolète.

Aryaka est le premier et le seul SD-WAN mondial, privé, optimisé, sécurisé et géré en tant que service qui offre simplicité et agilité pour répondre à tous les besoins des entreprises en matière de connectivité et de performance des applications.

Aryaka élimine le besoin d’appareils d’optimisation WAN, de MPLS et de CDN, offrant une connectivité optimisée et une accélération des applications en tant que service entièrement géré avec un coût total de possession réduit et un modèle de déploiement rapide.

Nous vous invitons à en savoir plus en nous contactant dès aujourd’hui, ou en téléchargeant notre dernière fiche technique sur notre solution de base pour les entreprises internationales.