Die Architekturen für die Bereitstellung von Netzwerksicherheit werden regelmäßig weiterentwickelt, was auf die verschiedenen Anforderungen von Unternehmen zurückzuführen ist.

Die Architekturen für die Bereitstellung von Netzwerksicherheit werden regelmäßig weiterentwickelt, was auf die verschiedenen Anforderungen von Unternehmen zurückzuführen ist.

Einige der jüngsten Trends in der Branche werden im Folgenden beschrieben:

- Minimierung der Kosten und des Wartungsaufwands, die mit unterschiedlichen und mehreren Netzwerksicherheitssystemen verbunden sind.

- Implementierung eines „Zero Trust Everywhere“-Mandats, das alle Netzwerke innerhalb von Rechenzentren, über WANs und innerhalb von Kubernetes-Clustern umfasst.

- Sicherstellung einer hohen Leistung (Durchsatz, reduzierte Latenz und minimaler Jitter), um das Benutzererlebnis zu verbessern und Echtzeitanwendungen wie WebRTC zu unterstützen.

- Anpassung an die Bedürfnisse einer verteilten Belegschaft.

- Erfüllen Sie die Anforderungen von Mitarbeitern im Außendienst.

- Verstärkte Nutzung von SaaS-Diensten durch Unternehmen.

- Wachsende Abhängigkeit von der Cloud für Unternehmensanwendungen.

- Umfassende Multi-Cloud-Implementierungen.

- Erforschung der potenziellen Vorteile von Edge- und Fog-Computing.

- Schwierigkeiten bei der Ausbildung oder Gewinnung von qualifiziertem Personal für Netzwerk- und Sicherheitsaufgaben.

- Minimierung der Ressourcen, die für die Verwaltung der Internetverbindung auf der letzten Meile für verteilte Büros erforderlich sind.

Veraltete Netzwerk- und Sicherheitsarchitektur

Unternehmen mit mehreren Niederlassungen und dezentralen Mitarbeitern haben traditionell erhebliche Ressourcen für die Beschaffung und Wartung ihrer Netzwerk- und Sicherheitsinfrastruktur aufgewendet.

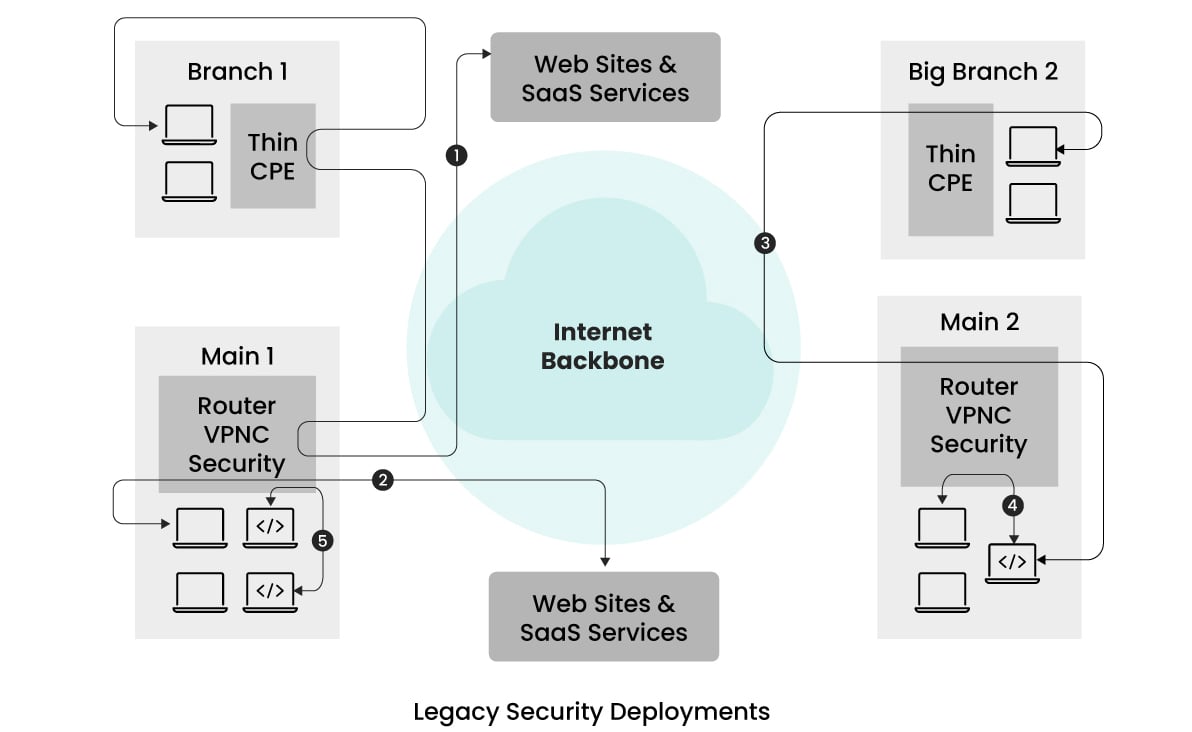

Die folgende vereinfachte Abbildung zeigt die typische Architektur, die früher verwendet wurde.  In diesem Beispiel geht es um ein Unternehmen mit zwei Zweigstellen und zwei Hauptniederlassungen, die über verschiedene Teile der Welt verteilt sind.

In diesem Beispiel geht es um ein Unternehmen mit zwei Zweigstellen und zwei Hauptniederlassungen, die über verschiedene Teile der Welt verteilt sind.

Um die Ausgaben für Sicherheits-Appliances zu senken und den Verwaltungsaufwand zu verringern, wird die gesamte Sicherheitsüberwachung in den Hauptniederlassungen zentralisiert.

Der Datenverkehr von den Zweigstellen und den Remote-Benutzern wird zur Durchsetzung der Sicherheit an die nahe gelegenen Hauptniederlassungen weitergeleitet, bevor er an sein Ziel weitergeleitet wird.

In den Zweigstellen werden in der Regel ‚Thin CPE‘-Geräte eingesetzt, um dieses Traffic-Tunneling zu erleichtern.

Die Hauptniederlassungen sind mit VPN-Konzentratoren ausgestattet, um die Tunnel abzuschließen, sowie mit mehreren Sicherheitsgeräten zur Erkennung und Beseitigung von Exploits, zur Implementierung granularer Zugriffskontrollen, zum Schutz vor Malware und zur Verhinderung von Phishing-Angriffen.

Wie in den Verkehrsströmen (in der Abbildung durch 1 dargestellt) zu sehen ist, folgt der Verkehr von den Zweigstellen zu den Internet-Sites jedoch einer haarfeinen Route.

Dieses Routing kann zu erhöhten Latenzzeiten und damit zu suboptimalen Benutzererfahrungen führen, insbesondere wenn die Zweigstelle und die nahe gelegene Hauptniederlassung weit voneinander entfernt sind.

Einige Unternehmen versuchten, den Durchsatz zu erhöhen und den Jitter zu verringern, indem sie dedizierte Verbindungen einsetzten. Diese Lösungen waren jedoch kostspielig und konnten die Latenzprobleme nicht angemessen lösen.

Darüber hinaus stellt die Verwaltung mehrerer Netzwerk- und Sicherheitsgeräte, von denen jedes über eine eigene Konfiguration und ein Analyse-Dashboard verfügt, eine Herausforderung dar.

Diese Komplexität kann zu fehleranfälligen Konfigurationen führen, da das Personal für mehrere Schnittstellen geschult werden muss.

Diese alten Sicherheitsarchitekturen vernachlässigten oft die Prinzipien des Null-Vertrauens und verließen sich eher auf die Netzwerksegmentierung und IP-Adressen als auf eine benutzerbasierte Zugriffskontrolle, die von der Authentifizierung der Benutzer abhängt.

Während dieser Ansatz zu dieser Zeit effektiv funktionierte, wurde die Identifizierung von Benutzern über IP-Adressen mit der Zunahme von Remote-Arbeitsszenarien und dem umfassenden Einsatz von NAT (Network Address Translation) immer schwieriger.

Infolgedessen begann diese Belastung, die Grenzen der alten Architekturen aufzuzeigen.

Cloud/POP bereitgestellte Sicherheit

Als Reaktion auf die Herausforderungen im Zusammenhang mit der Wartung der Sicherheitsinfrastruktur vor Ort, der Anpassung an die Anforderungen der Fernarbeit, der Verringerung der mit dem Datenverkehr verbundenen Latenz und der verstärkten Nutzung von Cloud- und SaaS-Diensten haben sich cloudbasierte Sicherheitslösungen als vielversprechende Alternative erwiesen.

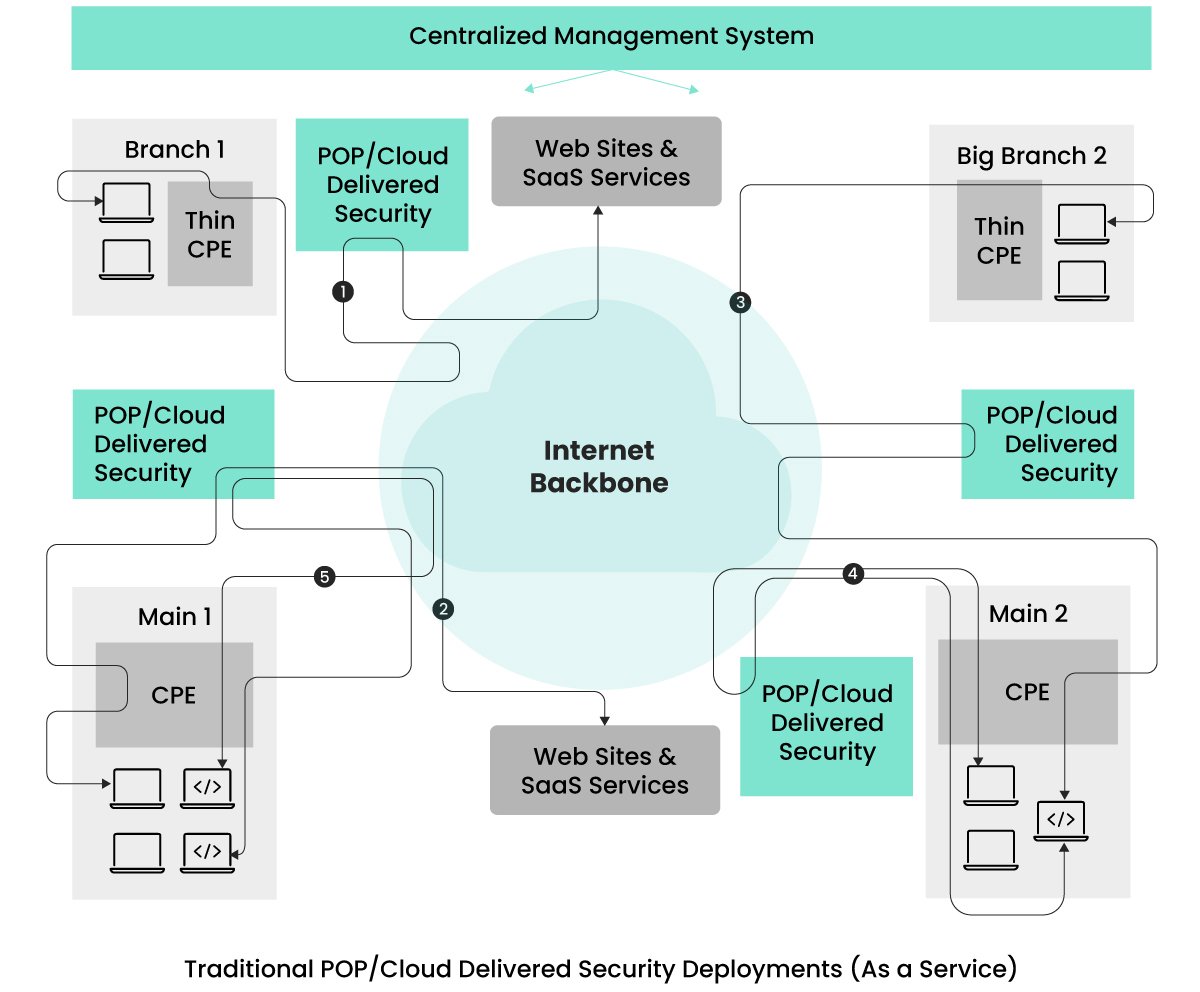

Viele Unternehmen haben damit begonnen, diese aus der Cloud bereitgestellten Sicherheitslösungen zu nutzen, um diese Probleme zu lösen, wie in der folgenden Abbildung dargestellt.  Die Sicherheitsdienste werden vom Anbieter über verschiedene Points of Presence (POPs) verteilt.

Die Sicherheitsdienste werden vom Anbieter über verschiedene Points of Presence (POPs) verteilt.

Unternehmen können die Standorte der POPs flexibel auswählen, je nachdem, wo sich ihre Büros befinden und wie viele Mitarbeiter an verschiedenen Standorten arbeiten.

Der Client-Datenverkehr, der für einen beliebigen Standort bestimmt ist, wird über den nächstgelegenen POP geleitet, an dem die Sicherheitsmaßnahmen durchgeführt werden.

Dieses Routing wird durch CPE-Geräte in den Büros und VPN-Client-Software auf den Geräten der Remote-Benutzer erleichtert, wodurch die Latenzzeit, die bei älteren Sicherheitsarchitekturen aufgrund der Nähe der POP-Standorte entsteht, reduziert wird.

Ursprünglich gab es in der Branche Sicherheitsdienste von mehreren Anbietern, aber es gibt eine Verlagerung hin zu Cloud-Sicherheitsdiensten, die auf einer einheitlichen Technologie basieren und von einem einzigen Anbieter stammen.

Diese einheitlichen Dienste bieten eine optimierte Verwaltung der Sicherheitskonfiguration und der Beobachtbarkeit und beheben damit die fragmentierte Sicherheitsverwaltung der alten Bereitstellungsarchitekturen.

Während dieser Aufbau für den Datenverkehr, der für das Internet/SaaS-Standorte bestimmt ist, gut funktioniert, stellt er eine neue Herausforderung dar, wenn sich beide kommunizierenden Einheiten am selben Standort, im selben Rechenzentrum oder innerhalb eines Kubernetes-Clusters befinden, wie in den Flüssen (4) und (5) zu sehen ist.

Fluss (4) zeigt, wie der Datenverkehr zwischen Einheiten innerhalb desselben Standorts zum nächstgelegenen POP-Standort getunnelt und dann zurück geleitet wird.

Dies geschieht, um Sicherheitsmaßnahmen für alle Verkehrsflüsse zu erzwingen und die Zero-Trust-Anforderungen zu erfüllen.

Fluss (5) veranschaulicht die Kommunikation zwischen zwei Anwendungsdiensten, die zur Erfüllung der Zero-Trust-Anforderungen zur Sicherheitsverarbeitung aus dem Standort heraus zum nächstgelegenen POP geleitet wird, bevor sie zum selben Kubernetes-Cluster zurückkehrt.

Dieser Prozess erhöht ungewollt die Latenz für diese Datenströme und kann den Datenverkehr unnötigerweise zusätzlichen Entitäten aussetzen.

Einige Unternehmen vermeiden diese Latenz, indem sie verschiedene Sicherheits-Appliances vor Ort einsetzen, was jedoch wieder zu Problemen führt, die mit älteren Bereitstellungsarchitekturen verbunden sind.

Eine weitere Herausforderung bei der von POP bereitgestellten Sicherheit ist die Leistungsisolierung.

Da diese Anbieter ihre Dienste mehreren Kunden/Mietern zur Verfügung stellen, kann es zu Leistungsproblemen kommen, die durch laute Nachbarn verursacht werden.

Das heißt, das Verkehrsaufkommen anderer Unternehmen kann sich auf die Verkehrsleistung Ihres Unternehmens auswirken.

Der Grund dafür ist die gemeinsame Nutzung desselben Ausführungskontextes für den Datenverkehr von mehreren Unternehmen.

Da Unternehmen nach Lösungen suchen, die Zero-Trust-Anforderungen erfüllen, eine einheitliche Richtlinienverwaltung bieten, eine Leistungsisolierung ermöglichen und unnötige Latenzzeiten durch Hair-Pinning verringern, hat die Netzwerksicherheitsbranche ihre Bereitstellungsarchitekturen weiterentwickelt, um diese Probleme anzugehen.

Unified Secure Access Service Edge (SASE), das von Unternehmen wie Aryaka angeboten wird, spielt in dieser Landschaft eine entscheidende Rolle.

Vereinheitlichte SASE mit hybriden und verteilten Sicherheitsdiensten

Eine ideale Architektur ist eine Architektur, die die Komplexität der Verwaltung in früheren Architekturen verringert, strenge Zero-Trust-Anforderungen erfüllt, ein gleiches Maß an Sicherheit für Nord-Süd- und Ost-West-Verkehrsströme gewährleistet, eine einheitliche Richtlinienverwaltung bietet, eine Leistungsisolierung ermöglicht und die mit Hair-Pinning verbundenen Latenzprobleme umgeht.

Unified SASE von Unternehmen wie Aryaka bietet eine Architektur, die viele der oben genannten Anforderungen erfüllt.

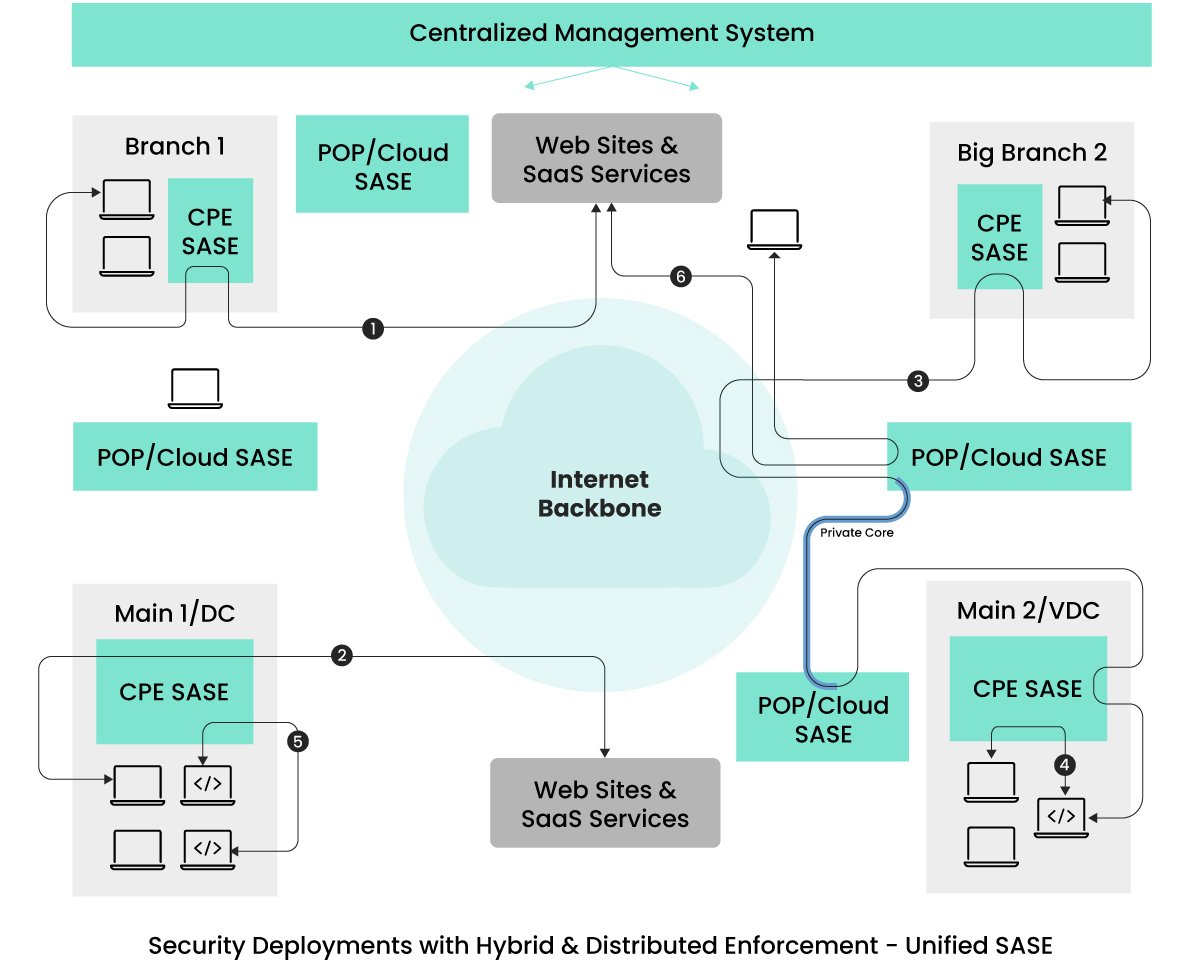

Bitte sehen Sie sich das folgende Bild an.  In der dargestellten Architektur erstrecken sich die Netzwerk- und Sicherheitsdurchsetzung über die POP/Cloud-Standorte hinaus auf die CPE-Geräte, die alle von demselben Dienstanbieter bereitgestellt und einheitlich verwaltet werden.

In der dargestellten Architektur erstrecken sich die Netzwerk- und Sicherheitsdurchsetzung über die POP/Cloud-Standorte hinaus auf die CPE-Geräte, die alle von demselben Dienstanbieter bereitgestellt und einheitlich verwaltet werden.

Diese Strategie mindert die Bedenken der Kunden hinsichtlich der Wartung dieser CPE-Geräte.

Nur wenn diese Geräte mit dem Datenverkehr überlastet sind, wird neuer Datenverkehr zur Durchsetzung der Sicherheit an nahe gelegene POP-Standorte geleitet.

Das Volumen des zu den POP-Standorten umgeleiteten Datenverkehrs hängt von den ausgewählten CPE-Gerätemodellen ab, wodurch der Ausweichverkehr reduziert wird.

Der Verkehr von Fernzugriffsbenutzern (dargestellt als 6) folgt einem ähnlichen Weg wie bei früheren Architekturen.

Der Datenverkehr von Remote-Benutzergeräten wird am nächstgelegenen POP-Standort einer Netzwerk- und Sicherheitsverarbeitung unterzogen, bevor er sein beabsichtigtes Ziel erreicht.

Die Datenflüsse (1) und (2) in dieser Architektur umgehen die POP-Standorte, so dass selbst minimale Latenzen, wie sie bei Cloud-Delivery-Konfigurationen auftreten, vermieden werden.

Darüber hinaus umgehen (4) und (5), die innerhalb eines Standorts stattfinden, nicht nur die Latenzzeiten, sondern reduzieren auch die Angriffsfläche.

Diese lokale Sicherheitsdurchsetzung ist für Echtzeitanwendungen wie WebRTC, die empfindlich auf Latenzprobleme reagieren, unerlässlich.

Für Anwendungsdienste an verschiedenen Standorten, die eine deterministische Leistung mit geringem Jitter erfordern, bieten einige SASE-Anbieter dedizierte Verbindungen zwischen den Standorten über die nächstgelegenen POP-Standorte an.

Fluss (3) ist ein Beispiel für einen Verkehrsfluss, der von dedizierter Bandbreite und Verbindungen profitiert und das Internet-Backbone umgeht, um einen deterministischen Jitter zu erreichen.

Es ist wichtig zu wissen, dass nicht alle Unified SASE-Angebote identisch sind.

Einige SASE-Anbieter leiten den gesamten Büroverkehr aus Gründen der Netzwerkoptimierung und Sicherheit immer noch an die nächstgelegenen POP-Standorte um.

Auch wenn sie mit mehreren POP-Standorten die Latenzzeit verringern, ist jede Verringerung der Latenzzeit für Unternehmen von Vorteil, insbesondere im Hinblick auf potenzielle Anforderungen von Anwendungen mit niedriger Latenzzeit.

Unternehmen werden wahrscheinlich nach Lösungen suchen, bei denen Benutzerfreundlichkeit und hohe Sicherheit im Vordergrund stehen, ohne dass die Leistung oder das Benutzererlebnis beeinträchtigt werden.

Da der Jitter zwischen den Niederlassungen gering sein muss, sollten Unternehmen Anbieter in Betracht ziehen, die dedizierte virtuelle Verbindungen zwischen den Niederlassungen anbieten, die das Internet-Backbone umgehen.

Ein weiterer wichtiger Faktor für Unternehmen ist die Auswahl von Anbietern, die Wartung und Software-Updates für SASE-CPE-Geräte verwalten.

Bei älteren Modellen trugen die Unternehmen die Verantwortung für Upgrades und Ersatzgeräte.

Um dies zu vermeiden, sollten Unternehmen Service Provider in Betracht ziehen, die umfassende verwaltete White-Glove-Services anbieten, die den gesamten Lebenszyklus der SASE-Infrastruktur abdecken und Aufgaben wie die Verwaltung von CPE-Geräten (Customer Premises Equipment), Konfiguration, Upgrades, Fehlerbehebung und Beobachtbarkeit umfassen.

Diese Anbieter übernehmen alle Aspekte des Netzwerks und der Sicherheit aus einer Hand und bieten gleichzeitig Co-Management- oder Self-Service-Optionen für Unternehmen an.

Blick in die Zukunft – Universal und Unified SASE

Obwohl der bestehende architektonische Rahmen, ‚Unified SASE with Distributed Security‘, mehrere in diesem Artikel beschriebene ursprüngliche Anforderungen zufriedenstellend erfüllt, gibt es zusätzliche Strategien zur Verbesserung der Anwendungsleistung ohne Beeinträchtigung der Sicherheitsintegrität.

Mit Blick auf die Zukunft erwarten wir Fortschritte bei der Durchsetzung der Sicherheit und der Optimierung des Datenverkehrs über die POPs und den Edge of the Offices hinaus.

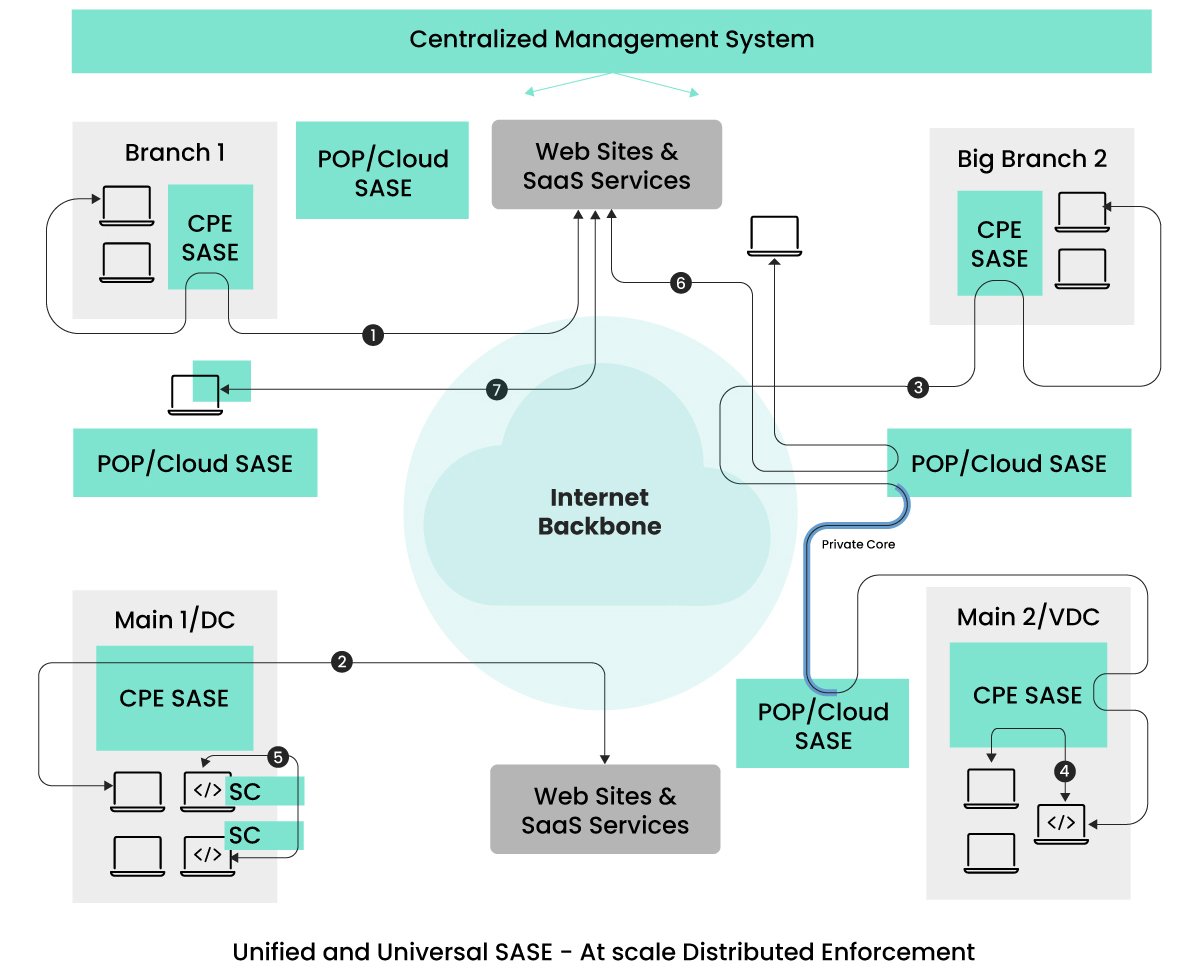

Diese neuen architektonischen Ansätze werden auf die Datenströme (5) und (7) abzielen, um insbesondere den Latenzaspekt der Leistung zu verbessern.  Wie in der Abbildung zu sehen ist, kann das Konzept, Sicherheit und Optimierung durchgängig zu implementieren, insbesondere am Ursprung des Datenverkehrs, eine optimale Leistung erzielen.

Wie in der Abbildung zu sehen ist, kann das Konzept, Sicherheit und Optimierung durchgängig zu implementieren, insbesondere am Ursprung des Datenverkehrs, eine optimale Leistung erzielen.

Die wichtigsten Verkehrsströme sind als (5) und (7) dargestellt.

Die Verbreitung von Mikro-/Mini-Service-basierten Anwendungsarchitekturen wird zum Standard in der Anwendungslandschaft.

Diese Mini-Dienste können innerhalb von Kubernetes-Clustern, über Cluster innerhalb von Rechenzentren oder über verschiedene geografische Standorte verteilt bereitgestellt werden.

In Szenarien, in denen kommunizierende Dienste innerhalb desselben Kubernetes-Clusters existieren, ist es vorteilhaft sicherzustellen, dass der Datenverkehr innerhalb des Clusters bleibt, was die Anwendung von Sicherheit und Optimierung direkt innerhalb der Kubernetes-Umgebung ermöglicht.

Kubernetes erleichtert das Hinzufügen von Sidecars zu den PODs, die die Mini-Services hosten.

Wir gehen davon aus, dass SASE-Anbieter diese Funktion in Zukunft nutzen werden, um umfassende Sicherheits- und Optimierungsfunktionen bereitzustellen, die die Anforderungen an die Vertrauenswürdigkeit erfüllen, ohne die Leistung zu beeinträchtigen.

Wenn Sie sich für einen einzigen universellen SASE-Anbieter entscheiden, erhalten Unternehmen eine einheitliche Verwaltungsschnittstelle für alle ihre Sicherheitsanforderungen, unabhängig von der Platzierung der kommunizierenden Dienste.

Fluss (5) in der Abbildung zeigt die Durchsetzung der Sicherheit über Seitenwagen (SC).

Es ist wichtig, darauf hinzuweisen, dass Sidecars in der Kubernetes-Welt nicht neu sind; Service-Mesh-Technologien verwenden einen ähnlichen Ansatz für das Verkehrsmanagement.

Einige Service-Mesh-Anbieter haben damit begonnen, Bedrohungssicherheit wie WAAP in die Sidecars zu integrieren.

In Anbetracht der Tatsache, dass Dienste mit dem Internet und anderen SaaS-Diensten kommunizieren können, sind umfassende Sicherheitsmaßnahmen unerlässlich.

Es ist daher absehbar, dass es in Zukunft zu einer Konvergenz von Service Mesh und SASE kommen wird, da Unternehmen eine umfassende und einheitliche Lösung suchen.

Der als (7) dargestellte Datenverkehr ist eine Überlegung, mit der sich viele SASE-Anbieter befassen. Dabei geht es nicht nur um die VPN-Client-Funktionalität, sondern auch um die Ausführung von SASE-Funktionen direkt auf dem Endpunkt.

Die Ausweitung von SASE auf die Endpunkte hilft, die mit POP-Standorten verbundenen Latenzprobleme zu umgehen.

Da die Endpunkte immer leistungsfähiger werden und bessere Kontrollmöglichkeiten bieten, um Dienstverweigerungen durch böswillige Organisationen zu verhindern, ist es möglich geworden, die SASE-Durchsetzung auf die Endpunkte auszuweiten.

Während Service Provider den Wartungsaufwand auf der SASE-Seite übernehmen, müssen Unternehmen unter Umständen noch sicherstellen, dass die Implementierung von SASE auf den Endpunkten keine neuen Probleme mit sich bringt.

Daher suchen Unternehmen nach Flexibilität bei der Ausweitung von SASE auf Endgeräte speziell für Power-User.

Abschließende Überlegungen

Dieser Artikel veranschaulicht die Entwicklung von Netzwerken und Sicherheit, indem er den Weg von Altsystemen zu modernen, aus der Cloud bereitgestellten Lösungen, Unified SASE mit verteilter Durchsetzung und zukünftigen Architekturen aufzeigt.

Es ist von entscheidender Bedeutung, die Unterschiede in den Lösungsangeboten zu erkennen.

Unternehmen müssen Service Provider gründlich evaluieren und nach „As-a-Service“-Lösungen suchen, die eine verteilte Durchsetzung über PoPs und CPE-Geräte hinweg abdecken und Betriebssystem- und Software-Upgrades umfassen, während gleichzeitig konsistente Verwaltungspraktiken beibehalten werden, die sowohl die Sicherheit als auch die Leistung gewährleisten.

Darüber hinaus ist es für Unternehmen entscheidend, verwaltete (oder gemeinsam verwaltete) Dienste von einem einzigen Anbieter zu bevorzugen.

Diese Dienste sollten nicht nur Internet-Konnektivitätslösungen mit fortschrittlichem technischem Support bieten, sondern sich auch schnell an neue Anforderungen anpassen und neue Bedrohungen abwehren.

Die Entscheidung für einen Managed Service Provider, der As-a-Service von anderen SASE-Anbietern nutzt, kann bei zukünftigen Erweiterungen zu Komplikationen führen, die langwierige Verhandlungen zwischen Managed Service- und Technologieanbietern nach sich ziehen.

Angesichts des dringenden Bedarfs an schnellen Lösungen bin ich der Meinung, dass Unified SASE-Lösungen mit umfassenden Managed Service-Angeboten von einem Anbieter die ideale Wahl für Unternehmen sind.

-

CTO Insights Blog

Die Blogserie Aryaka CTO Insights bietet Denkanstöße zu Netzwerk-, Sicherheits- und SASE-Themen.

Aryaka Produktspezifikationen finden Sie in den Aryaka Datenblättern.