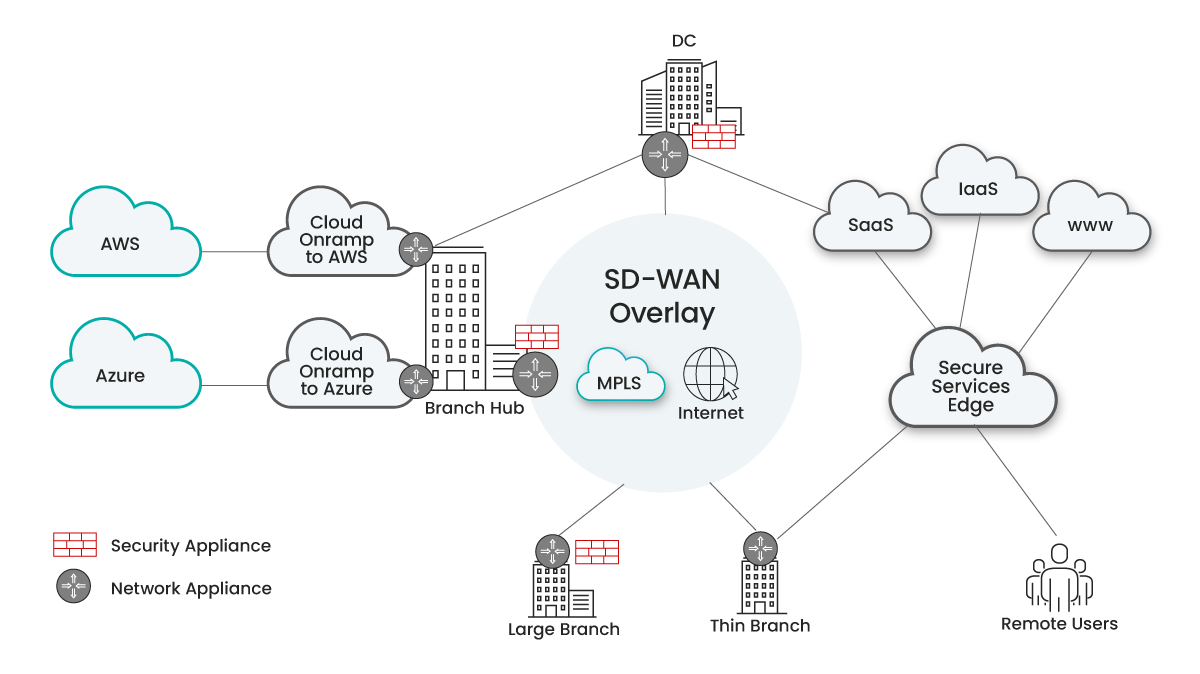

Die WAN-Netzwerke und die Netzwerksicherheit haben sich in den letzten 20 Jahren rasant entwickelt. Vor dem Jahr 2000 waren WAN-Netzwerke relativ einfach, mit privaten Netzwerken (wie MPLS und Mietleitungen) in Kombination mit zentralisierten Firewalls in den Zentralen und Rechenzentren. Damals arbeiteten die meisten Mitarbeiter vom Büro aus und waren an ein Kabel gebunden; von einer Cloud konnte keine Rede sein. Die Außendienstmitarbeiter waren mit einem zentralen VPN-Konzentrator verbunden. Private Netzwerke boten zwar eine leistungsstarke, kontrollierte Erfahrung, aber sie waren teuer. Angesichts der begrenzten Anzahl von Fernarbeitern wurde eine unterdurchschnittliche Erfahrung jedoch nicht als signifikantes Problem angesehen. In den Zweigstellen gab es so gut wie keine Firewalls, und eine zentral gelegene Firewall schützte die Verbindungen zum Internet. Die Netzwerk- und Sicherheitsteams waren in getrennten Silos organisiert und arbeiteten nur gelegentlich miteinander zusammen. In den letzten 25 Jahren hat eine ganze Reihe neuer Technologien die etablierte Ordnung durcheinander gebracht, darunter Wi-Fi im Jahr 1997, Breitband-Internet im Jahr 2000, WAN-Optimierung im Jahr 2002, Cloud-Dienste im Jahr 2006, Cloud-Sicherheit im Jahr 2008, SD-WAN im Jahr 2012 und SASE (Secure Access Service Edge) im Jahr 2019. Infolgedessen haben sich IT- und Sicherheitsorganisationen mit drei grundlegenden Fragen auseinandergesetzt: Frage eins: Wo soll der Breakout zum Internet platziert werden? Bevor Wi-Fi allgegenwärtig wurde, war es üblich, den gesamten Internetverkehr über das private WAN zu einem zentralen Standort zu leiten, an dem eine Reihe von Firewalls die Grenzen des Unternehmens schützte. Mit der zunehmenden Verbreitung von Wi-Fi und Cloud Computing begann jedoch das Backhauling großer Mengen von Internetverkehr über teure private Verbindungen die Anwendungsleistung zu beeinträchtigen. Daher gibt es einen wachsenden Trend, den Internet-Breakout in Zweigstellen zu platzieren und dort Firewalls zu installieren, trotz der zusätzlichen Kosten und des erhöhten Sicherheitsrisikos. Die Cloud-Sicherheit kam 2008 zur Rettung und bot eine ideale Lösung für kleinere Büros und Außendienstmitarbeiter, die es ihnen ermöglichte, die Firewalls vor Ort fernzuhalten und den Außendienstmitarbeitern die Haare auszureißen. Für große Standorte und Rechenzentren blieb die NextGen Firewall vor Ort bestehen, was die Herausforderung mit sich brachte, dass die Sicherheitsrichtlinien nun zwischen Cloud- und Vor-Ort-Sicherheit aufgeteilt waren. Zweite Frage: Wie kann billigeres Internet genutzt werden, um die WAN-Kosten von Unternehmen zu senken? Die meisten Unternehmen haben aus Gründen der Einfachheit und der Sicherheit davon abgesehen, ihre Büros direkt mit dem Internet zu verbinden. Als jedoch die Einführung von Wi-Fi und Cloud die IT-Manager in Zugzwang brachte und das Internet in allen Büros Einzug hielt, wurde die Internetkonnektivität zunehmend als Möglichkeit gesehen, die WAN-Kosten zu senken. Dies begünstigt die Einführung von SD-WAN, das Pfadsteuerung und Optimierungsfunktionen nutzt, um die erforderliche Anwendungsleistung zu erzielen, indem es bei Bedarf den optimalen Pfad (Internet oder MPLS) verwendet. Der größte Vorteil von SD-WAN war die Kostensenkung, da der Bedarf an teurem (und unflexiblem) MPLS so weit wie möglich reduziert wurde, indem der WAN-Verkehr über Internetleitungen geleitet wurde. Heute haben viele Unternehmen MPLS sogar ganz abgeschafft und durch (duale) Internetverbindungen ersetzt. Das Internet ist jedoch eine Best-Effort-Technologie mit uneinheitlichen Latenzzeiten und ohne Bandbreitengarantie. Dies hat den Bedarf an einem verbesserten Internet mit einer Betriebszeitgarantie und besser vorhersehbaren Latenzzeiten entstehen lassen. Angesichts der explosionsartigen Zunahme von Anwendungen im WAN wollen Netzwerkmanager außerdem jede Ursache für eine schlechte Anwendungsleistung beseitigen. Außerdem wurde mit der Zunahme des ortsunabhängigen Arbeitens deutlich, dass Mitarbeiter, die an entfernten Standorten arbeiten, die gleiche Erfahrung wie Büroangestellte machen müssen. Herkömmliche SD-WAN-Lösungen konzentrierten sich in erster Linie auf die Konnektivität von Büros, was häufig zu einer erhöhten Netzwerkkomplexität und einem höheren Verwaltungsaufwand führte. Frage 3: Welche Cloud-Onramp-Architektur lässt sich am besten an die sich ständig ändernden Cloud-Anforderungen anpassen? Mit der weit verbreiteten Einführung von Cloud-Diensten stehen Unternehmen nun vor der Herausforderung, die Verbindungen zwischen ihrem WAN und den Cloud-Anbietern zu verwalten. Dies erfordert spezielle Cloud-Onramps, die Verbindungen von mehreren Büros und Remote-Benutzern auf eine einzige Verbindung zum IaaS-Standort eines bestimmten Cloud-Anbieters zusammenfassen. Cloud-Onramps sind kostspielig, da jeder Onramp bestimmte Aggregationspunkte an einem bestimmten Ort erfordert. Darüber hinaus müssen sich diese Cloud-Onramps in den allgemeinen Sicherheitsrahmen des Unternehmens einfügen, der häufig eine Kombination aus Firewalls vor Ort und Cloud-Sicherheit umfasst, die sowohl den Internet-Breakout-Nutzungsfall als auch Site-to-Site-Verbindungen abdeckt. Das Endergebnis: IT-Organisationen sitzen mit Frankenstein-Netzwerken fest.“ IT-Organisationen haben sich schwer getan, einfache Antworten auf die drei oben genannten Fragen zu finden und stehen nun vor einer komplexen und schwierigen Situation. Es bleibt ein Flickenteppich aus separaten SDWAN-Implementierungen zur Anbindung von Zweigstellen, Cloud-Onramps und Sicherheitsimplementierungen für Cloud- und On-Premises-Sicherheit. Diese unterschiedlichen Implementierungen stammen oft von mehreren Anbietern und mit separaten Verwaltungstools, was zu einer komplexen und schwerfälligen Lösung führt, die verwaltet und gepflegt werden muss. Dieses „Frankenstein-Netzwerk“ ist komplex und führt zu schlechter Leistung, inkonsistenten Sicherheitsrichtlinien und einem Mangel an Transparenz und Kontrolle, was es schwierig macht, Probleme schnell und effizient zu lösen.

Die WAN-Netzwerke und die Netzwerksicherheit haben sich in den letzten 20 Jahren rasant entwickelt. Vor dem Jahr 2000 waren WAN-Netzwerke relativ einfach, mit privaten Netzwerken (wie MPLS und Mietleitungen) in Kombination mit zentralisierten Firewalls in den Zentralen und Rechenzentren. Damals arbeiteten die meisten Mitarbeiter vom Büro aus und waren an ein Kabel gebunden; von einer Cloud konnte keine Rede sein. Die Außendienstmitarbeiter waren mit einem zentralen VPN-Konzentrator verbunden. Private Netzwerke boten zwar eine leistungsstarke, kontrollierte Erfahrung, aber sie waren teuer. Angesichts der begrenzten Anzahl von Fernarbeitern wurde eine unterdurchschnittliche Erfahrung jedoch nicht als signifikantes Problem angesehen. In den Zweigstellen gab es so gut wie keine Firewalls, und eine zentral gelegene Firewall schützte die Verbindungen zum Internet. Die Netzwerk- und Sicherheitsteams waren in getrennten Silos organisiert und arbeiteten nur gelegentlich miteinander zusammen. In den letzten 25 Jahren hat eine ganze Reihe neuer Technologien die etablierte Ordnung durcheinander gebracht, darunter Wi-Fi im Jahr 1997, Breitband-Internet im Jahr 2000, WAN-Optimierung im Jahr 2002, Cloud-Dienste im Jahr 2006, Cloud-Sicherheit im Jahr 2008, SD-WAN im Jahr 2012 und SASE (Secure Access Service Edge) im Jahr 2019. Infolgedessen haben sich IT- und Sicherheitsorganisationen mit drei grundlegenden Fragen auseinandergesetzt: Frage eins: Wo soll der Breakout zum Internet platziert werden? Bevor Wi-Fi allgegenwärtig wurde, war es üblich, den gesamten Internetverkehr über das private WAN zu einem zentralen Standort zu leiten, an dem eine Reihe von Firewalls die Grenzen des Unternehmens schützte. Mit der zunehmenden Verbreitung von Wi-Fi und Cloud Computing begann jedoch das Backhauling großer Mengen von Internetverkehr über teure private Verbindungen die Anwendungsleistung zu beeinträchtigen. Daher gibt es einen wachsenden Trend, den Internet-Breakout in Zweigstellen zu platzieren und dort Firewalls zu installieren, trotz der zusätzlichen Kosten und des erhöhten Sicherheitsrisikos. Die Cloud-Sicherheit kam 2008 zur Rettung und bot eine ideale Lösung für kleinere Büros und Außendienstmitarbeiter, die es ihnen ermöglichte, die Firewalls vor Ort fernzuhalten und den Außendienstmitarbeitern die Haare auszureißen. Für große Standorte und Rechenzentren blieb die NextGen Firewall vor Ort bestehen, was die Herausforderung mit sich brachte, dass die Sicherheitsrichtlinien nun zwischen Cloud- und Vor-Ort-Sicherheit aufgeteilt waren. Zweite Frage: Wie kann billigeres Internet genutzt werden, um die WAN-Kosten von Unternehmen zu senken? Die meisten Unternehmen haben aus Gründen der Einfachheit und der Sicherheit davon abgesehen, ihre Büros direkt mit dem Internet zu verbinden. Als jedoch die Einführung von Wi-Fi und Cloud die IT-Manager in Zugzwang brachte und das Internet in allen Büros Einzug hielt, wurde die Internetkonnektivität zunehmend als Möglichkeit gesehen, die WAN-Kosten zu senken. Dies begünstigt die Einführung von SD-WAN, das Pfadsteuerung und Optimierungsfunktionen nutzt, um die erforderliche Anwendungsleistung zu erzielen, indem es bei Bedarf den optimalen Pfad (Internet oder MPLS) verwendet. Der größte Vorteil von SD-WAN war die Kostensenkung, da der Bedarf an teurem (und unflexiblem) MPLS so weit wie möglich reduziert wurde, indem der WAN-Verkehr über Internetleitungen geleitet wurde. Heute haben viele Unternehmen MPLS sogar ganz abgeschafft und durch (duale) Internetverbindungen ersetzt. Das Internet ist jedoch eine Best-Effort-Technologie mit uneinheitlichen Latenzzeiten und ohne Bandbreitengarantie. Dies hat den Bedarf an einem verbesserten Internet mit einer Betriebszeitgarantie und besser vorhersehbaren Latenzzeiten entstehen lassen. Angesichts der explosionsartigen Zunahme von Anwendungen im WAN wollen Netzwerkmanager außerdem jede Ursache für eine schlechte Anwendungsleistung beseitigen. Außerdem wurde mit der Zunahme des ortsunabhängigen Arbeitens deutlich, dass Mitarbeiter, die an entfernten Standorten arbeiten, die gleiche Erfahrung wie Büroangestellte machen müssen. Herkömmliche SD-WAN-Lösungen konzentrierten sich in erster Linie auf die Konnektivität von Büros, was häufig zu einer erhöhten Netzwerkkomplexität und einem höheren Verwaltungsaufwand führte. Frage 3: Welche Cloud-Onramp-Architektur lässt sich am besten an die sich ständig ändernden Cloud-Anforderungen anpassen? Mit der weit verbreiteten Einführung von Cloud-Diensten stehen Unternehmen nun vor der Herausforderung, die Verbindungen zwischen ihrem WAN und den Cloud-Anbietern zu verwalten. Dies erfordert spezielle Cloud-Onramps, die Verbindungen von mehreren Büros und Remote-Benutzern auf eine einzige Verbindung zum IaaS-Standort eines bestimmten Cloud-Anbieters zusammenfassen. Cloud-Onramps sind kostspielig, da jeder Onramp bestimmte Aggregationspunkte an einem bestimmten Ort erfordert. Darüber hinaus müssen sich diese Cloud-Onramps in den allgemeinen Sicherheitsrahmen des Unternehmens einfügen, der häufig eine Kombination aus Firewalls vor Ort und Cloud-Sicherheit umfasst, die sowohl den Internet-Breakout-Nutzungsfall als auch Site-to-Site-Verbindungen abdeckt. Das Endergebnis: IT-Organisationen sitzen mit Frankenstein-Netzwerken fest.“ IT-Organisationen haben sich schwer getan, einfache Antworten auf die drei oben genannten Fragen zu finden und stehen nun vor einer komplexen und schwierigen Situation. Es bleibt ein Flickenteppich aus separaten SDWAN-Implementierungen zur Anbindung von Zweigstellen, Cloud-Onramps und Sicherheitsimplementierungen für Cloud- und On-Premises-Sicherheit. Diese unterschiedlichen Implementierungen stammen oft von mehreren Anbietern und mit separaten Verwaltungstools, was zu einer komplexen und schwerfälligen Lösung führt, die verwaltet und gepflegt werden muss. Dieses „Frankenstein-Netzwerk“ ist komplex und führt zu schlechter Leistung, inkonsistenten Sicherheitsrichtlinien und einem Mangel an Transparenz und Kontrolle, was es schwierig macht, Probleme schnell und effizient zu lösen.

Die typischen Frankenstein-Netzwerke von heute

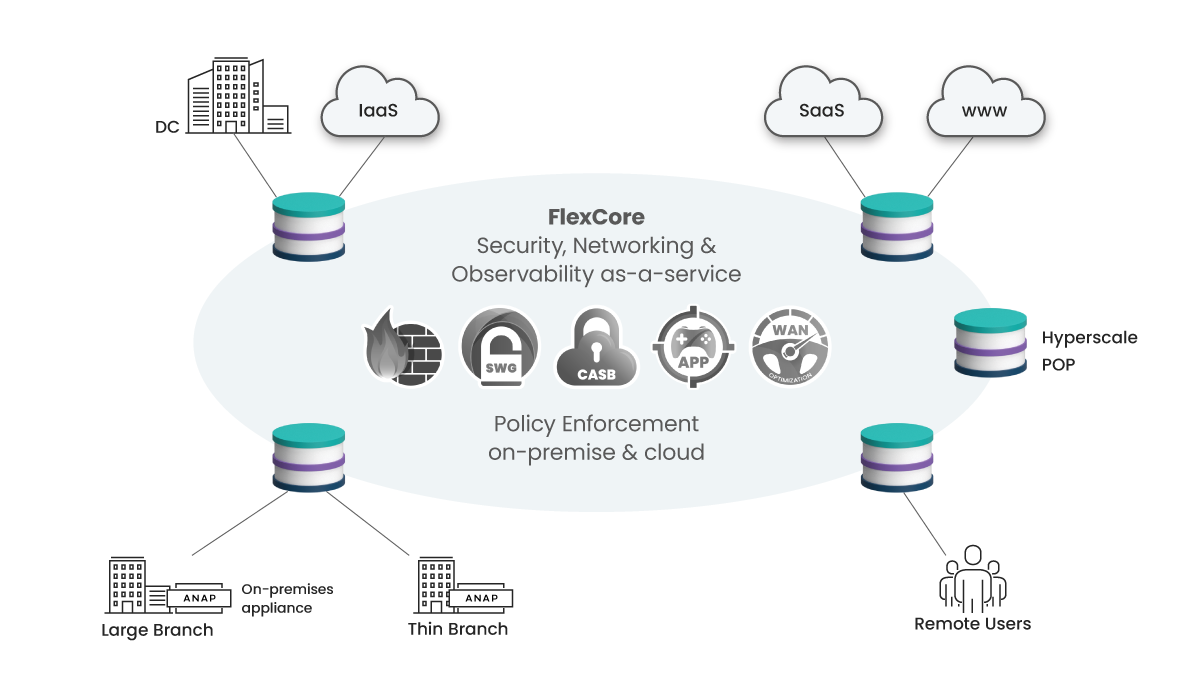

„Die SASE-Lösung von Aryaka: Das Ende der Frankenstein-Netzwerke“

Das Aufkommen von Frankenstein-Netzwerken hat dazu geführt, dass IT-Organisationen nach einer Lösung suchen, und SASE hat sich als Antwort darauf erwiesen. Der Ansatz von Aryaka für SASE beginnt mit einer hochleistungsfähigen Netzwerkgrundlage, die sichere Verbindungen zwischen Benutzern und Anwendungen unabhängig vom Standort ermöglicht, und zwar unter einer Reihe von vollständig vereinheitlichten Richtlinien für Netzwerk und Sicherheit. Durch die Durchsetzung von Sicherheitsrichtlinien so nah wie möglich an den Benutzern und Anwendungen, ob in der Cloud oder vor Ort, werden Leistungsengpässe in Übereinstimmung mit dem Zero-Trust-Prinzip beseitigt. Das Netzwerkfundament muss den unflexiblen Flickenteppich separater Netzwerke, die Zweigstellen, Benutzer, Rechenzentren und die Cloud verbinden, beseitigen und als konsumierbarer Cloud-Service bereitgestellt werden, der auch Funktionen vor Ort umfasst. Darüber hinaus muss eine flexible Netzwerkinfrastruktur drei Service-Levels anbieten, um die WAN-Kosten zu optimieren: Best-Effort-Internet, Better-than-Internet und Better-than-MPLS, wobei das alte MPLS vollständig abgeschafft wird. Es ist oft erwähnenswert, dass aktuelle SASE-Implementierungen einzelner Anbieter oberflächlich betrachtet SASE-Lösungen zu sein scheinen, aber unter der Haube können sie immer noch Frankenstein-Netzwerke sein, die die zugrunde liegende Architektur nicht bereinigt haben.

Aryakas Unified SASE auf einer FlexCore Foundation

Das Ergebnis des Ansatzes von Aryaka ist eine einfach zu nutzende SASE-Lösung, von der Kunden profitieren, indem sie allen Benutzern, Anwendungen und Workloads ein hochsicheres und leistungsstarkes Erlebnis bietet. Diese einfache Nutzung wird durch eine Cloud-native Infrastruktur ermöglicht, die aus einer deterministischen Kontrolle des Netzwerk-Underlay besteht, kombiniert mit einer Single-Path-Architektur von Netzwerk-, Optimierungs- und Sicherheitsfunktionen mit integrierten Service-Workflows. Agilität und Flexibilität sind die grundlegenden Vorteile für die Kunden, da sie ihre Netzwerk- und Sicherheitsinfrastruktur nun im Gleichschritt mit dem unaufhörlichen digitalen Wandel weiterentwickeln können. Außerdem können Benutzer mit diesem Ansatz schnell umziehen und Zweigstellen verlagern, ohne dass alle paar Jahre Technologien und Anbieter ausgetauscht werden müssen, wenn neue Herausforderungen auftreten. Außerdem können teure Cloud-Onramps eliminiert werden, ohne dass kostspielige Upgrades der Netzwerkinfrastruktur erforderlich sind. Netzwerk-SLAs (Service Level Agreements), die von Best Effort bis zu garantierter Anwendungsleistung reichen, können je nach den Bedürfnissen der Benutzer und der Art der Anwendungen sofort geändert werden. Die SASE-Lösung von Aryaka mit ihrer einfachen Nutzung, Agilität, Flexibilität und den Managed Services bietet Kunden ein leistungsstarkes Werkzeug, um Frankenstein-Netzwerke zu eliminieren und die Kontrolle über ihre Netzwerk- und Sicherheitsinfrastruktur zu übernehmen.